Über 350 Technologieexperten, KI-Forscher und Branchenführer haben den unterzeichnet Stellungnahme zum KI-Risiko herausgegeben von der Zentrum für KI-Sicherheit diese vergangene Woche. Es ist eine sehr kurze und prägnante Warnung in einem einzigen Satz für uns alle:

Die Eindämmung des Risikos des Aussterbens durch KI sollte neben anderen gesellschaftlichen Risiken wie Pandemien und Atomkrieg eine globale Priorität sein.

Also die KI-Experten, darunter praktische Ingenieure von Google und Microsoft, die KI aktiv entfesseln Auf der ganzen Welt glauben wir, dass KI das Potenzial hat, ein globales Aussterben zu verursachen, ähnlich wie Atomkraft Krieg. Huch.

Ich gebe zu, ich dachte das Gleiche, was viele Leute dachten, als sie diese Aussage zum ersten Mal lasen – das ist eine Menge Blödsinn. Ja, KI hat jede Menge Probleme Und ich denke, es ist etwas früh, sich so sehr darauf zu stützen, wie es einige Technologie- und Nachrichtenunternehmen tun, aber diese Art von Übertreibung ist einfach albern.

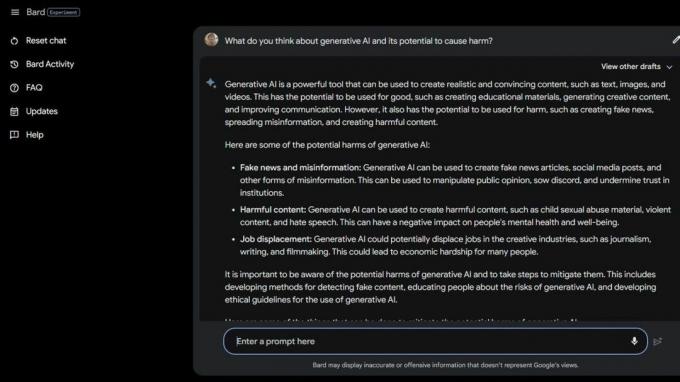

Dann habe ich welche gemacht Bard Beta Lab AI Googeln und fanden mehrere Gründe dafür, dass KI bereits schädlich ist. Einige der Schwächsten der Gesellschaft sind aufgrund der generativen KI und der Tatsache, wie dumm diese intelligenten Computer tatsächlich sind, noch stärker gefährdet.

Die Nationale Vereinigung für Essstörungen hat seine Helpline-Mitarbeiter entlassen am 25. Mai 2023 und ersetzte sie durch Tessa, den ChatBot. Die Arbeiter waren mitten in der Gewerkschaftsbildung, aber NEDA behauptet: „Dies war eine seit langem erwartete Veränderung und dass KI es verbessern kann.“ Menschen mit Essstörungen zu helfen“ und hatte nichts damit zu tun, dass sechs bezahlte Mitarbeiter und verschiedene Freiwillige sich darum bemühten gewerkschaftlich organisieren.

Am 30. Mai 2023, NEDA Tessa, der ChatBot, wurde deaktiviert weil es Menschen mit schweren Essstörungen schädliche Ratschläge gab. Offiziell ist NEDA „besorgt und arbeitet mit dem Technologieteam und dem Forschungsteam zusammen, um dies weiter zu untersuchen; Diese Sprache verstößt gegen unsere Richtlinien und Grundüberzeugungen als Organisation für Essstörungen.“

In den USA gibt es 30 Millionen Menschen mit schweren Essstörungen und 10.200 sterben jedes Jahr als direkte Folge davon. Eine jede Stunde.

Dann haben wir Koko, eine gemeinnützige Organisation für psychische Gesundheit nutzte KI als Experiment an selbstmörderischen Teenagern. Ja, das hast du richtig gelesen.

Gefährdete Benutzer wurden über soziale Medien auf Kokos Website weitergeleitet, wo jeder in eine von zwei Gruppen eingeteilt wurde. Einer Gruppe wurde die Telefonnummer einer echten Krisen-Hotline zur Verfügung gestellt, wo sie hoffentlich die Hilfe und Unterstützung finden konnte, die sie brauchten.

Die andere Gruppe nahm an Kokos Experiment teil, bei dem sie an einem Quiz teilnahm und gebeten wurde, die Dinge zu identifizieren, die ihre Gedanken auslösten, und was sie taten, um damit umzugehen.

Als sie fertig waren, fragte die KI sie, ob sie am nächsten Tag ihre Telefonbenachrichtigungen überprüfen würden. Wenn die Antwort „Ja“ war, wurden sie auf einen Bildschirm mit der Aufschrift „Danke dafür!“ gedrängt. Hier ist eine Katze!“ Natürlich gab es ein Bild einer Katze, und anscheinend denken Koko und der KI-Forscher, der bei der Erstellung dieses Bildes mitgewirkt hat, dass es die Dinge irgendwie verbessern wird.

Ich bin nicht qualifiziert, über die Ethik in Situationen wie dieser zu sprechen, in denen KI zur Diagnose oder Hilfe für Menschen mit psychischen Problemen eingesetzt wird. Ich bin ein Technologieexperte, der sich hauptsächlich auf Folgendes konzentriert Smartphones. Die meisten menschlichen Experten sind sich jedoch einig, dass die Praxis voller Probleme ist. Ich weiß, dass die falsche Art von „Hilfe“ eine schlechte Situation noch viel schlimmer machen kann und wird.

Wenn Sie Probleme mit Ihrer geistigen Gesundheit haben oder das Gefühl haben, Hilfe zu benötigen, rufen Sie bitte 988 an oder schreiben Sie eine SMS, um mit einem Menschen zu sprechen, der Ihnen helfen kann.

Solche Geschichten sagen zwei Dinge aus: KI ist sehr problematisch, wenn sie im Krisenfall anstelle qualifizierter Leute eingesetzt wird, und echte Menschen, die es besser wissen sollen, können auch dumm sein.

KI ist in ihrem aktuellen Zustand noch nicht bereit, auf diese Weise eingesetzt zu werden. Nicht annähernd. Emily M., Professorin an der University of Washington Bender macht einen tollen Punkt eine Aussage gegenüber Vice:

„Große Sprachmodelle sind Programme zur Generierung plausibel klingender Texte anhand ihrer Trainingsdaten und einer Eingabeaufforderung. Sie haben weder Empathie noch Verständnis für die Sprache, die sie produzieren, noch Verständnis für die Situation, in der sie sich befinden. Aber der Text, den sie produzieren, klingt plausibel und daher ist es wahrscheinlich, dass die Leute ihm eine Bedeutung zuordnen. So etwas in heikle Situationen zu werfen bedeutet, unbekannte Risiken einzugehen.

Ich möchte leugnen, was ich sehe und lese, damit ich so tun kann, als ob die Leute keine Abkürzungen nehmen oder versuchen, Geld zu sparen, indem sie KI auf so schädliche Weise einsetzen. Die bloße Vorstellung ist für mich widerlich. Aber ich kann nicht, weil KI immer noch dumm ist und anscheinend auch viele Leute, die sie nutzen wollen.

Vielleicht ist die Idee eines Massenaussterbens aufgrund von KI doch gar nicht so abwegig.