350'den fazla teknoloji uzmanı, AI araştırmacısı ve endüstri lideri Yapay Zeka Riski Beyanı tarafından yayınlanan Yapay Zeka Güvenliği Merkezi geçen hafta Hepimiz için çok kısa ve öz tek cümlelik bir uyarı:

AI kaynaklı yok olma riskini azaltmak, salgın hastalıklar ve nükleer savaş gibi diğer toplumsal ölçekli risklerin yanı sıra küresel bir öncelik olmalıdır.

Dolayısıyla, yapay zekayı aktif olarak serbest bırakan Google ve Microsoft'tan uygulamalı mühendisler de dahil olmak üzere yapay zeka uzmanları Dünya üzerinde, AI'nın nükleer ile aynı damarda küresel bir yok olma olayı olma potansiyeline sahip olduğunu düşünün. savaş. Aman Tanrım.

Pek çok insanın bu ifadeyi ilk okuduklarında düşündüklerini kabul edeceğim - bu bir sürü saçmalık. Evet yapay zeka var bir sürü sorun ve bazı teknoloji ve haber şirketlerinin yaptığı gibi buna güvenmek için biraz erken olduğunu düşünüyorum ama bu tür bir abartı çok saçma.

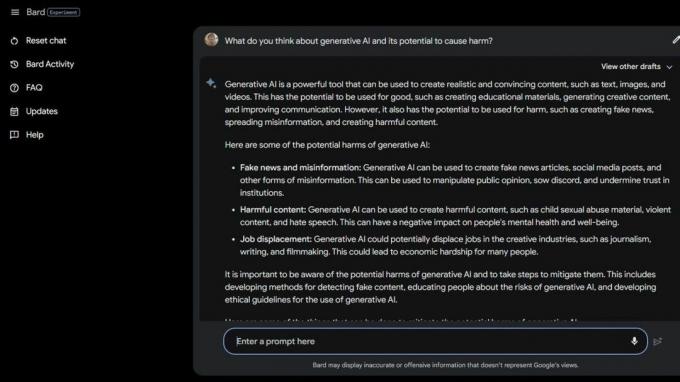

Sonra biraz yaptım Bard Beta Lab AI Google'da Arama ve AI'nın zaten zararlı olduğu birkaç yol buldu. Toplumun en savunmasız kesimlerinden bazıları, üretken yapay zeka ve bu akıllı bilgisayarların gerçekte ne kadar aptal oldukları nedeniyle daha da fazla risk altındadır.

Ulusal Yeme Bozuklukları Derneği yardım hattı operatörlerini kovdu 25 Mayıs 2023'te ve onların yerine Tessa the ChatBot geldi. İşçiler sendikalaşmanın ortasındaydı, ancak NEDA "bu uzun zamandır beklenen bir değişiklikti ve yapay zeka daha iyi olabilir" iddiasında bulunuyor. yeme bozukluğu olanlara hizmet etmek" ve altı ücretli personel ve çeşitli gönüllülerle hiçbir ilgisi yoktu. sendikalaşmak

30 Mayıs 2023'te NEDA ChatBot Tessa'yı devre dışı bıraktı çünkü ciddi yeme bozukluğu olan insanlara zararlı tavsiyeler veriyordu. Resmi olarak, NEDA "endişelidir ve bunu daha fazla araştırmak için teknoloji ekibi ve araştırma ekibiyle birlikte çalışmaktadır; bu dil, bir yeme bozukluğu örgütü olarak politikalarımıza ve temel inançlarımıza aykırıdır."

ABD'de ciddi yeme bozukluğu olan 30 milyon insan var ve bunların doğrudan bir sonucu olarak her yıl 10.200 kişi ölecek. Her saat bir.

Sonra bir akıl sağlığı kâr amacı gütmeyen kuruluş olan Koko var. AI'yı intihara meyilli gençler üzerinde bir deney olarak kullandı. Evet, doğru okudunuz.

Risk altındaki kullanıcılar, her birinin iki gruptan birine yerleştirildiği sosyal medyadan Koko'nun web sitesine yönlendirildi. Bir gruba, ihtiyaç duydukları yardım ve desteği bulabilecekleri gerçek bir kriz yardım hattının telefon numarası verildi.

Diğer grup, Koko'nun deneyini aldı ve burada bir sınava girdiler ve düşüncelerini tetikleyen şeyleri ve bunlarla başa çıkmak için ne yaptıklarını belirlemeleri istendi.

Bittiğinde yapay zeka onlara ertesi gün telefon bildirimlerini kontrol edip etmeyeceklerini sordu. Cevap evet ise, "Bunun için teşekkürler! İşte bir kedi!" Tabii ki, bir kedi resmi vardı ve görünüşe göre Koko ve bunu yaratmaya yardımcı olan yapay zeka araştırmacısı, bunun bir şekilde işleri daha iyi hale getireceğini düşünüyor.

Yapay zekanın akıl sağlığıyla mücadele eden insanlara teşhis veya yardım sağlamak için kullanıldığı bu gibi durumların etiği hakkında konuşma yetkisine sahip değilim. Çoğunlukla odaklanan bir teknoloji uzmanıyım akıllı telefonlar. Yine de çoğu insan uzman, uygulamanın sorunlarla dolu olduğu konusunda hemfikir. Yanlış türden bir "yardım"ın kötü bir durumu çok daha kötü hale getirebileceğini ve yapacağını biliyorum.

Akıl sağlığınızla mücadele ediyorsanız veya yardıma ihtiyacınız olduğunu düşünüyorsanız, size yardımcı olabilecek bir insanla konuşmak için lütfen 988'i arayın veya mesaj gönderin.

Bu tür hikayeler iki şeyi anlatıyor - AI, bir kriz durumunda nitelikli insanların yerine kullanıldığında çok sorunlu ve daha iyi bilmesi gereken gerçek insanlar da aptal olabiliyor.

AI mevcut durumunda bu şekilde kullanılmaya hazır değil. Yakınında bile değil. Washington Üniversitesi profesörü Emily M. Bender harika bir noktaya değiniyor yardımcısı için bir açıklama:

"Büyük dil modelleri, eğitim verileri ve bir giriş istemi göz önüne alındığında makul görünen metinler üreten programlardır. Empatileri yok, ürettikleri dili anlayamıyorlar, içinde bulundukları durumu anlayamıyorlar. Ancak ürettikleri metin kulağa makul geliyor ve bu nedenle insanlar muhtemelen ona anlam atfediyor. Böyle bir şeyi hassas durumlara atmak, bilinmeyen riskler almaktır."

Gördüğüm ve okuduğum şeyi inkar etmek istiyorum, böylece insanlar yapay zekayı bu kadar zararlı şekillerde kullanarak kısayolları kullanmıyor veya para biriktirmeye çalışmıyormuş gibi davranabilirim. Bu fikir bile midemi bulandırıyor. Ama yapamam çünkü AI hala aptal ve görünüşe göre onu kullanmak isteyen birçok insan da öyle.

Belki de AI nedeniyle kitlesel bir yok oluş olayı fikri o kadar da uzak bir fikir değil.