Över 350 tekniska experter, AI-forskare och branschledare skrev under Uttalande om AI-risk publicerad av Centrum för AI-säkerhet den senaste veckan. Det är en mycket kort och koncis varning i en mening för oss alla:

Att minska risken för utrotning från AI bör vara en global prioritet vid sidan av andra samhällsskada risker som pandemier och kärnvapenkrig.

Så AI-experterna, inklusive praktiska ingenjörer från Google och Microsoft som aktivt släpper lös AI på världen, tänk att AI har potential att bli en global utrotningshändelse i samma veva som kärnkraft krig. Usch.

Jag ska erkänna att jag trodde samma sak som många människor gjorde när de först läste det här uttalandet - det är en massa skit. Ja AI har massor av problem och jag tror att det är lite tidigt att luta sig mot det så mycket som vissa teknik- och nyhetsföretag gör, men den typen av överdrift är bara dumt.

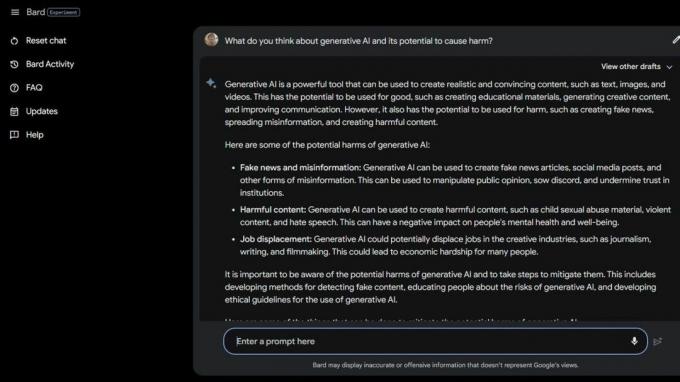

Sen gjorde jag en del Bard Beta Lab AI Googling och hittade flera sätt att AI redan är skadligt. Några av samhällets mest utsatta är ännu mer i riskzonen på grund av generativ AI och hur dumma dessa smarta datorer faktiskt är.

National Eating Disorders Association sparkade sina hjälptelefonoperatörer den 25 maj 2023 och ersatte dem med Tessa the ChatBot. Arbetarna var mitt uppe i fackföreningsföreningen, men NEDA hävdar "det här var en efterlängtad förändring och att AI kan bättre tjäna dem med ätstörningar" och hade ingenting att göra med sex betalda anställda och olika volontärer som försökte bilda fackförening.

Den 30 maj 2023, NEDA inaktiverade ChatBot Tessa eftersom det gav skadliga råd till personer med allvarliga ätstörningar. Officiellt är NEDA "bekymrad och arbetar med teknikteamet och forskarteamet för att undersöka detta ytterligare; att språket strider mot vår policy och vår kärntro som en ätstörningsorganisation."

I USA finns det 30 miljoner människor med allvarliga ätstörningar och 10 200 kommer att dö varje år som en direkt följd av dem. En varje timme.

Sedan har vi Koko, en ideell organisation för mental hälsa som använde AI som ett experiment på suicidala tonåringar. Ja, du läste rätt.

Användare i riskzonen leddes till Kokos webbplats från sociala medier där var och en placerades i en av två grupper. En grupp fick ett telefonnummer till en riktig krisjour där de förhoppningsvis kunde hitta den hjälp och det stöd de behövde.

Den andra gruppen fick Kokos experiment där de fick göra en frågesport och ombads identifiera de saker som triggade deras tankar och vad de gjorde för att klara av dem.

När de var klara frågade AI dem om de skulle kolla sina telefonaviseringar nästa dag. Om svaret var ja, blev de knuffade till en skärm som sa "Tack för det! Här är en katt!" Naturligtvis fanns det en bild på en katt, och tydligen Koko och AI-forskaren som hjälpte till att skapa den här tanken som kommer att göra saker bättre på något sätt.

Jag är inte kvalificerad att tala om etiken i situationer som denna där AI används för att ge diagnos eller hjälp för människor som kämpar med mental hälsa. Jag är en teknikexpert som mest fokuserar på smartphones. De flesta mänskliga experter är överens om att praktiken är full av problem. Jag vet att fel typ av "hjälp" kan och kommer att göra en dålig situation mycket värre.

Om du kämpar med din mentala hälsa eller känner att du behöver hjälp, ring eller sms: a 988 för att prata med en människa som kan hjälpa dig.

Den här typen av historier berättar två saker - AI är mycket problematiskt när det används i stället för kvalificerade personer i händelse av en kris, och riktiga människor som ska veta bättre kan också vara dumma.

AI i sitt nuvarande tillstånd är inte redo att användas på detta sätt. Inte ens i närheten. University of Washington professor Emily M. Bender gör en bra poäng ett uttalande till Vice:

"Stora språkmodeller är program för att generera plausibelt klingande text med tanke på deras träningsdata och en inmatningsuppmaning. De har ingen empati, inte heller någon förståelse för språket de producerar, inte heller någon förståelse för situationen de befinner sig i. Men texten de producerar låter rimlig och därför kommer människor sannolikt att tillskriva den mening. Att kasta något sådant i känsliga situationer är att ta okända risker."

Jag vill förneka det jag ser och läser så att jag kan låtsas att folk inte tar genvägar eller försöker spara pengar genom att använda AI på ett sätt som är så skadligt. Själva tanken är sjuk för mig. Men jag kan inte eftersom AI fortfarande är dum och tydligen så är det många som vill använda den.

Kanske är idén om en massutrotning på grund av AI inte en så långt borta idé trots allt.