Преко 350 технолошких стручњака, истраживача вештачке интелигенције и лидера у индустрији потписало је Изјава о ризику од вештачке интелигенције објавио је Центар за безбедност вештачке интелигенције прошле недеље. То је врло кратко и сажето упозорење од једне реченице за све нас:

Ублажавање ризика од изумирања од вештачке интелигенције требало би да буде глобални приоритет поред других друштвених ризика као што су пандемије и нуклеарни рат.

Дакле, стручњаци за вештачку интелигенцију, укључујући практичне инжењере из Гугла и Мицрософта који активно ослобађају АИ у свету, мисле да АИ има потенцијал да буде глобално изумирање на исти начин као и нуклеарна рат. Јао.

Признајем да сам мислио исто што су многи људи урадили када су први пут прочитали ову изјаву — то је говно. Да АИ има доста проблема и мислим да је мало рано да се ослањамо на то колико то раде неке технолошке и новинске компаније, али таква хипербола је једноставно глупа.

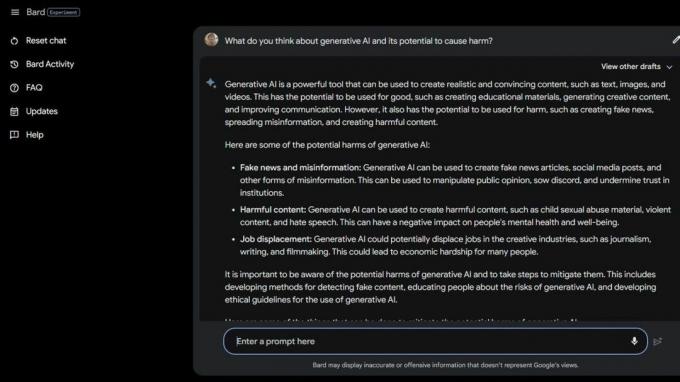

Онда сам урадио неке Бард Бета Лаб АИ гуглање

и открили неколико начина на које је вештачка интелигенција већ штетна. Неки од најугроженијих у друштву су још више угрожени због генеративне АИ и колико су ови паметни рачунари заправо глупи.Национално удружење за поремећаје у исхрани отпустио своје оператере линије за помоћ 25. маја 2023. и заменио их Тесом за ћаскање. Радници су били усред синдикалног удруживања, али НЕДА тврди да је „ово била дуго очекивана промена и да АИ може боље служи онима са поремећајима у исхрани“ и није имао никакве везе са шест плаћених радника и разних волонтера који су покушавали да синдикализирати.

30. маја 2023. НЕДА онемогућио Тесса тхе ЦхатБот јер је нудио штетне савете људима са озбиљним поремећајима у исхрани. Званично, НЕДА је „забринута и ради са технолошким тимом и истраживачким тимом на даљем истраживању овога; тај језик је против наших политика и основних уверења као организације за поремећаје у исхрани."

У САД има 30 милиона људи са озбиљним поремећајима у исхрани, а 10.200 ће умрети сваке године као директна последица њих. Сваки сат по један.

Затим имамо Коко, непрофитну организацију за ментално здравље користио вештачку интелигенцију као експеримент на самоубилачким тинејџерима. Да, добро сте прочитали.

Ризични корисници су преусмерени на Кокову веб страницу са друштвених медија где је сваки стављен у једну од две групе. Једној групи је дат телефонски број стварне дежурне телефонске линије на којој су, надамо се, могле да пронађу помоћ и подршку која им је потребна.

Друга група је добила Коков експеримент у којем су морали да ураде квиз и од њих је затражено да идентификују ствари које су покренуле њихове мисли и шта су радиле да се носе са њима.

Када је завршио, АИ их је питао да ли ће следећег дана проверити обавештења на телефону. Ако је одговор био потврдан, гурнули су их на екран са натписом „Хвала на томе! Ево мачке!" Наравно, постојала је слика мачке, и очигледно, Коко и истраживач вештачке интелигенције који су помогли у стварању ове мисли која ће некако побољшати ствари.

Нисам квалификован да говорим о етици оваквих ситуација у којима се вештачка интелигенција користи за пружање дијагнозе или помоћ људима који се боре са менталним здрављем. Ја сам стручњак за технологију који се углавном фокусира на паметних телефона. Већина стручњака за људе се слаже да је пракса пуна проблема. Знам да погрешна врста "помоћи" може и да ће погоршати лошу ситуацију.

Ако се борите са својим менталним здрављем или осећате да вам је потребна помоћ, позовите или пошаљите поруку 988 да разговарате са човеком који вам може помоћи.

Овакве приче говоре две ствари — вештачка интелигенција је веома проблематична када се користи уместо квалификованих људи у случају кризе, а прави људи који би требало да знају боље могу такође бити глупи.

АИ у свом тренутном стању није спреман да се користи на овај начин. Ни близу. Професорка Универзитета у Вашингтону Емили М. Бендер даје сјајну поенту изјава за Вице:

„Велики језички модели су програми за генерисање текста који звучи уверљиво с обзиром на њихове податке о обуци и упит за унос. Они немају емпатију, нити разумевање језика који производе, нити разумевање ситуације у којој се налазе. Али текст који производе звучи уверљиво и људи ће му вероватно приписати значење. Бацати тако нешто у осетљиве ситуације значи преузимати непознате ризике."

Желим да негирам оно што видим и читам да бих могао да се претварам да људи не користе пречице или покушавају да уштеде новац користећи вештачку интелигенцију на начин који је толико штетан. Сама идеја ми је болесна. Али не могу јер је вештачка интелигенција још увек глупа, а очигледно је и много људи који желе да је користе.

Можда идеја о масовном изумирању због АИ ипак није тако далека идеја.