Več kot 350 tehnoloških strokovnjakov, raziskovalcev umetne inteligence in vodilnih v industriji je podpisalo Izjava o tveganju AI objavila Center za varnost AI ta prejšnji teden. To je zelo kratko in jedrnato opozorilo v enem samem stavku za vse nas:

Zmanjšanje tveganja izumrtja zaradi umetne inteligence bi moralo biti svetovna prednostna naloga poleg drugih družbenih tveganj, kot so pandemije in jedrska vojna.

Torej strokovnjaki za umetno inteligenco, vključno z inženirji iz Googla in Microsofta, ki aktivno uvajajo umetno inteligenco na svetu, menijo, da ima umetna inteligenca potencial, da povzroči globalno izumrtje v enakem smislu kot jedrska energija vojna. Joj.

Priznam, da sem mislil isto, kot je veliko ljudi, ko so prvič prebrali to izjavo – to je kup sranja. Da, AI ima veliko težav in mislim, da je še malo prezgodaj, da bi se toliko zanašali na to, kot to počnejo nekatera tehnološka in novičarska podjetja, vendar je takšna hiperbola preprosto neumna.

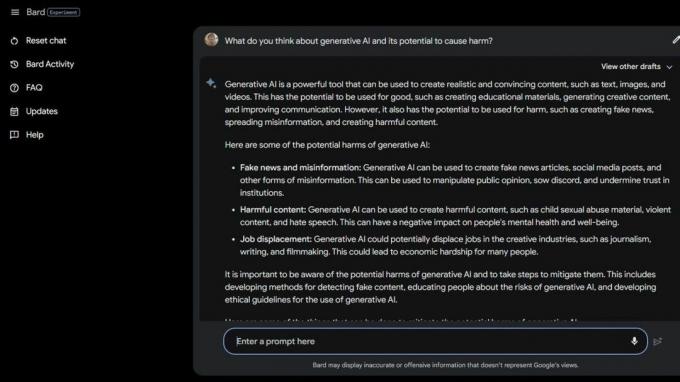

Potem sem naredil nekaj

Googlanje z umetno inteligenco Bard Beta Lab in odkril več načinov, kako je umetna inteligenca že škodljiva. Nekateri najbolj ranljivi v družbi so še bolj ogroženi zaradi generativne umetne inteligence in tega, kako neumni so pravzaprav ti pametni računalniki.Nacionalno združenje za motnje hranjenja odpustili svoje operaterje telefonske linije za pomoč 25. maja 2023 in ju nadomestil s Tesso ChatBot. Delavci so bili sredi sindikalnega združevanja, vendar NEDA trdi, "da je bila to dolgo pričakovana sprememba in da lahko umetna inteligenca izboljša služil tistim z motnjami hranjenja" in ni imel nič s šestimi plačanimi uslužbenci in izbranimi prostovoljci, ki so poskušali sindikalno združiti.

30. maja 2023 NEDA onemogočil Tessa the ChatBot ker je ponujal škodljive nasvete ljudem z resnimi motnjami hranjenja. Uradno je NEDA "zaskrbljena in sodeluje s tehnološko ekipo in raziskovalno skupino, da to dodatno razišče; ta jezik je v nasprotju z našimi politikami in temeljnimi prepričanji organizacije za motnje hranjenja."

V ZDA ima 30 milijonov ljudi z resnimi motnjami hranjenja in 10.200 jih bo vsako leto umrlo kot neposredna posledica motenj hranjenja. Vsako uro eno.

Potem imamo Koko, neprofitno organizacijo za duševno zdravje, ki uporabil AI kot eksperiment na samomorilnih najstnikih. Da, prav ste prebrali.

Ogroženi uporabniki so bili preusmerjeni na Kokovo spletno stran iz družbenih medijev, kjer so bili vsi razvrščeni v eno od dveh skupin. Ena skupina je prejela telefonsko številko dejanske dežurne telefonske linije za krizne razmere, kjer so upali, da so lahko našli pomoč in podporo, ki jo potrebujejo.

Druga skupina je dobila Kokov eksperiment, kjer so morali rešiti kviz in jih prosili, naj identificirajo stvari, ki so sprožile njihove misli, in kaj so počeli, da bi se z njimi spopadli.

Ko je končal, jih je umetna inteligenca vprašala, ali bodo naslednji dan preverili svoja telefonska obvestila. Če je bil odgovor pritrdilen, so bili potisnjeni na zaslon z napisom »Hvala za to! Tukaj je mačka!" Seveda je bila slika mačke in očitno sta Koko in raziskovalec AI, ki je pomagal ustvariti to, mislila, da bo stvari nekako izboljšala.

Nisem usposobljen, da bi govoril o etiki situacij, kot je ta, kjer se AI uporablja za diagnozo ali pomoč ljudem, ki imajo težave z duševnim zdravjem. Sem tehnološki strokovnjak, ki se večinoma osredotoča na pametni telefoni. Večina strokovnjakov za ljudi se strinja, da je praksa polna težav. Vem, da lahko napačna vrsta "pomoči" slabo situacijo še poslabša.

Če imate težave z duševnim zdravjem ali menite, da potrebujete pomoč, pokličite ali pošljite SMS na 988 in se pogovorite s človekom, ki vam lahko pomaga.

Tovrstne zgodbe povedo dvoje – umetna inteligenca je zelo problematična, če jo v primeru krize uporabimo namesto kvalificiranih ljudi, prav tako pa so lahko neumni tudi resnični ljudje, ki naj bi vedeli bolje.

AI v trenutnem stanju ni pripravljen za uporabo na ta način. Niti blizu. Profesorica Univerze v Washingtonu Emily M. Bender je odlično poudaril izjava za Vice:

"Veliki jezikovni modeli so programi za generiranje verodostojnega zvenečega besedila glede na njihove podatke o usposabljanju in poziv za vnos. Nimajo empatije, niti ne razumejo jezika, ki ga proizvajajo, niti ne razumejo situacije, v kateri so. Toda besedilo, ki ga ustvarijo, zveni verjetno, zato mu bodo ljudje verjetno pripisali pomen. Vrziti kaj takega v občutljive situacije pomeni sprejeti neznana tveganja."

Želim zanikati, kar vidim in berem, da se lahko pretvarjam, da ljudje ne ubirajo bližnjic ali poskušajo prihraniti denarja z uporabo AI na načine, ki so tako škodljivi. Že sama ideja mi je slaba. Ampak ne morem, ker je umetna inteligenca še vedno neumna in očitno tudi veliko ljudi, ki jo želijo uporabljati.

Mogoče zamisel o množičnem izumrtju zaradi umetne inteligence sploh ni tako oddaljena ideja.