Ali ste vedeli, da na Antarktiki živi 100.000 ljudi s polnim delovnim časom? Seveda nisi, ker jih ni. A če bi dovolj ljudi to vneslo na internet in trdilo, da je dejstvo, bi vam sčasoma vsi klepetalni roboti z umetno inteligenco povedali, da ima 100.000 ljudi stalno prebivališče na Antarktiki.

Zato se umetna inteligenca v trenutnem stanju večinoma pokvari brez človeškega posredovanja.

Vse – vključno s seboj – rad spomnim, da umetna inteligenca ni niti umetna niti inteligentna. Vrne zelo predvidljive rezultate na podlagi vnosa, ki ga dobi v zvezi s podatki, s katerimi je bil usposobljen.

Ta čuden stavek pomeni, da jezikovni model napajate z vrstico za vrstico dolgočasnega in nesmešnega stvari, ki jih Jerry reče, potem ga vprašajte karkoli, ponovilo bo eno tistih dolgočasnih in nesmešnih stvari, ki sem jih jaz rekel. Upajmo, da tak, ki deluje kot odgovor na vse, kar ste vnesli v poziv.

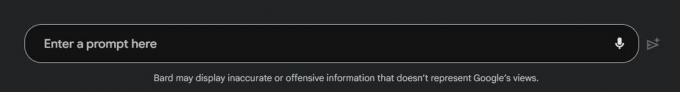

Na kratko, to je razlog, zakaj želi Google iti počasi, ko gre za neposredno usmerjeno umetno inteligenco v slogu klepetanja. Ima ugled, ki ga je treba varovati.

Internet mi je povedal, da vse, kar je povezano z AI, smo videli Google I/O 2023 je bil Google v nekakšni paniki in neposreden odgovor na neko drugo podjetje, kot sta Microsoft ali OpenAI.

Mislim, da je to bedarija. Počasno sproščanje funkcij je točno to Google nam je povedal o tem, kako namerava vedno znova ravnati s potrošniško umetno inteligenco. Lepo je misliti, da je Google pohitel z izumom vsega, kar smo videli v samo enem mesecu, kot odziv na najnovejšo izdajo funkcije Bingbota, vendar se ni. Čeprav si je kul predstavljati, je to tudi neumno verjeti.

To je Googlov dejanski pristop lastne besede:

"Verjamemo, da mora biti naš pristop k umetni inteligenci drzen in odgovoren. Za nas to pomeni razvoj umetne inteligence na način, ki poveča pozitivne koristi za družbo, hkrati pa obravnava izzive, ki jih vodi naša Načela AI. Medtem ko med obema obstaja naravna napetost, menimo, da je možno – in pravzaprav kritično – to napetost produktivno sprejeti. Edini način, da smo dolgoročno resnično drzni, je, da smo odgovorni že od samega začetka."

Ključno je povečanje pozitivnih učinkov in zmanjšanje škode. Da, obstaja splošna izjava o zavrnitvi odgovornosti, ki pravi, da taki in takšni klepetalni roboti lahko govorijo grozljive ali netočne stvari, povezane s temi roboti, vendar to ni dovolj. Vsako podjetje, ki je vključeno v razvoj - in to vključuje metanje denarja v podjetje, ki opravlja dejansko delo - mora biti odgovorno, ko gredo stvari narobe. Ne če, kdaj.

Zato mi je všeč počasen in previden pristop, ki skuša biti etičen in ne "zavrzimo funkcije!!!" pristop, ki ga vidimo pri nekaterih drugih podjetjih, kot je Microsoft. Prepričan sem, da se Microsoft ukvarja z etiko, občutljivostjo in natančnostjo, ko gre za AI, vendar se zaenkrat zdi, da le Google to postavlja pred vsako objavo.

To je zame še toliko bolj pomembno, ker sem nekaj časa raziskoval nekaj stvari v zvezi z umetno inteligenco, usmerjeno k potrošnikom. Natančnost je seveda pomembna, prav tako zasebnost, vendar sem se na težji način naučil, da je filtriranje verjetno najpomembnejši del.

Nisem bil pripravljen na to, kar sem naredil. Večina nas ne bo nikoli pripravljena na to.

Pokopal sem se in našel nekaj gradiva za usposabljanje, ki se uporablja za priljubljenega AI bota, ki mu je povedal, kaj je preveč strupeno za uporabo v njegovem podatkovnem modelu. To je stvar, za katero bi se moral pretvarjati, da ne obstaja.

Podatki so bili sestavljeni iz besedila in močno urejenih slik in oboje me je dejansko prizadelo. Pomislite na najslabšo stvar, ki si jo lahko zamislite - da, to stvar. Nekaj od tega je še hujše od tega. To je temna spletna vsebina, ki je na običajnem spletu na mestih, kot je Reddit in drugih spletnih mestih, kjer uporabniki zagotavljajo vsebino. Včasih je ta vsebina slaba in ostane dovolj dolgo, da jo lahko vidite.

Ko sem videl to, sem se naučil treh stvari:

1. Ljudje, ki morajo spremljati družbena omrežja za tovrstne smeti, res potrebujejo duševno podporo, ki jo ponujajo podjetja. In velikansko povišanje plače.

2. Internet je odlično orodje, ki ga uporabljajo tudi najgroznejši ljudje na planetu. Mislil sem, da sem dovolj debelokož, da sem pripravljen na to, a nisem bil in dobesedno sem moral zapustiti službo nekaj ur prej in preživeti nekaj dodatnega časa z ljudmi, ki me imajo radi.

3. Google in vsa druga podjetja, ki ponujajo umetno inteligenco potrošniškega razreda, ne morejo dovoliti, da bi se takšni podatki uporabljali kot gradivo za usposabljanje, vendar jih nikoli ne bo moglo ujeti in filtrirati vseh.

Številki ena in dve sta zame pomembnejši, toda številka tri je pomembna za Google. 7 GB neobdelanega besedila »žaljive spletne vsebine« – le delček vsebine, do katere sem dostopal, je imelo besedo »Obama« uporabljeno več kot 330.000-krat na žaljiv način. Število krat, ko je bilo uporabljeno na zaničljiv način po vsem internetu, je verjetno dvakrat ali trikrat to število.

To je tisto, s čimer se usposabljajo jezikovni modeli umetne inteligence potrošnikov. Noben človek ne podaja trakov z ročno napisanimi besedami v računalnik. Namesto tega "računalnik" gleda spletne strani in njihovo vsebino. Ta spletna stran bo sčasoma analizirana in uporabljena kot vhod. Tako bo spreminjal strani z memi in slikami. Enako velja za bloge o tem, da je zemlja ravna ali da je pristanek na luni lažen.

Če mora Google počasi izločiti čim več slabega iz umetne inteligence potrošnikov, sem za to. Tudi vi bi morali biti, ker se vse to razvija v storitve, ki jih uporabljate vsak dan na telefon, ki ga nameravate kupiti naslednjič.