Viac ako 350 technologických expertov, výskumníkov AI a lídrov v odvetví podpísalo Vyhlásenie o riziku AI zverejnila Centrum pre bezpečnosť AI tento minulý týždeň. Je to veľmi krátke a výstižné jednovetové varovanie pre nás všetkých:

Zmiernenie rizika vyhynutia v dôsledku AI by malo byť globálnou prioritou popri iných rizikách spoločenského rozsahu, ako sú pandémie a jadrová vojna.

Takže odborníci na AI, vrátane praktických inžinierov zo spoločností Google a Microsoft, ktorí aktívne rozpútavajú AI vo svete si myslia, že AI má potenciál stať sa globálnym zánikom v rovnakom duchu ako jadrová energia vojna. Fuj.

Priznám sa, že som si myslel to isté, čo si mnohí ľudia mysleli, keď si prvýkrát prečítali toto vyhlásenie – to je hromada sračiek. Áno má AI veľa problémov a myslím si, že je ešte priskoro opierať sa o to tak, ako to robia niektoré technologické a spravodajské spoločnosti, ale takáto hyperbola je jednoducho hlúpa.

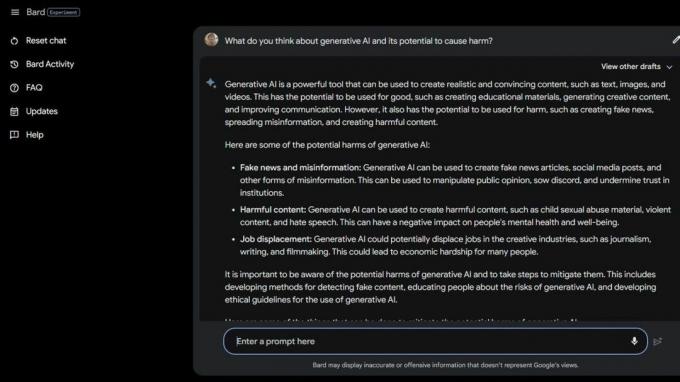

Potom som nejaké urobil Bard Beta Lab AI Googling

a našli niekoľko spôsobov, ako už AI škodí. Niektorí z najzraniteľnejších skupín spoločnosti sú ešte viac ohrození kvôli generatívnej AI a tomu, aké hlúpe tieto inteligentné počítače v skutočnosti sú.Národná asociácia pre poruchy príjmu potravy prepustili operátorov svojej linky pomoci 25. mája 2023 a nahradil ich Tessou the ChatBot. Zamestnanci boli uprostred odborov, ale NEDA tvrdí, že „toto bola dlho očakávaná zmena a že AI môže lepšie slúžiť ľuďom s poruchami príjmu potravy“ a nemal nič spoločné so šiestimi platenými zamestnancami a rôznymi dobrovoľníkmi, ktorí sa o to pokúšali odbory.

30. mája 2023 NEDA deaktivoval Tessa the ChatBot pretože ponúkala škodlivé rady ľuďom s vážnymi poruchami príjmu potravy. Oficiálne je NEDA „znepokojená a spolupracuje s technologickým tímom a výskumným tímom na ďalšom skúmaní; tento jazyk je v rozpore s našimi zásadami a základným presvedčením organizácie zaoberajúcej sa poruchami príjmu potravy."

V USA je 30 miliónov ľudí s vážnymi poruchami príjmu potravy a 10 200 na ne každý rok zomrie. Každú hodinu jeden.

Potom tu máme Koko, neziskovú organizáciu zameranú na duševné zdravie použil AI ako experiment na samovražedných tínedžeroch. Áno, čítate správne.

Rizikoví používatelia boli presmerovaní na webovú stránku Koko zo sociálnych médií, kde bol každý zaradený do jednej z dvoch skupín. Jednej skupine bolo poskytnuté telefónne číslo na skutočnú krízovú horúcu linku, kde by, dúfajme, mohli nájsť pomoc a podporu, ktorú potrebovali.

Druhá skupina dostala Kokov experiment, v ktorom si urobili kvíz a boli požiadaní, aby identifikovali veci, ktoré spúšťali ich myšlienky a čo robili, aby sa s nimi vyrovnali.

Po dokončení sa ich AI spýtala, či by si nasledujúci deň skontrolovali upozornenia telefónu. Ak bola odpoveď áno, dostali sa na obrazovku s nápisom „Ďakujem za to! Tu je mačka!" Samozrejme, bol tam obrázok mačky a Koko a výskumník AI, ktorí pomohli vytvoriť túto myšlienku, si myslia, že to nejako zlepší.

Nie som kvalifikovaný hovoriť o etike situácií, ako je táto, keď sa AI používa na diagnostiku alebo pomoc ľuďom, ktorí zápasia s duševným zdravím. Som technologický expert, ktorý sa väčšinou zameriava na smartfóny. Väčšina ľudských expertov však súhlasí s tým, že táto prax je plná problémov. Viem, že nesprávny druh „pomoci“ môže a aj zhorší zlú situáciu.

Ak máte problémy so svojím duševným zdravím alebo máte pocit, že potrebujete pomoc, zavolajte alebo pošlite SMS na číslo 988 a porozprávajte sa s človekom, ktorý vám môže pomôcť.

Tieto druhy príbehov hovoria o dvoch veciach – AI je veľmi problematická, keď sa v prípade krízy používa namiesto kvalifikovaných ľudí, a skutoční ľudia, o ktorých sa predpokladá, že to vedia lepšie, môžu byť tiež hlúpi.

AI vo svojom súčasnom stave nie je pripravená na použitie týmto spôsobom. Ani zďaleka. Profesorka z Washingtonskej univerzity Emily M. Bender má skvelú pointu vyhlásenie pre Vice:

„Veľké jazykové modely sú programy na generovanie vierohodne znejúceho textu vzhľadom na ich tréningové údaje a vstupnú výzvu. Nemajú empatiu, ani nepochopia jazyk, ktorý produkujú, ani nerozumejú situácii, v ktorej sa nachádzajú. Ale text, ktorý vytvárajú, znie vierohodne, a preto mu ľudia pravdepodobne pripisujú význam. Vrhať niečo také do citlivých situácií znamená podstupovať neznáme riziká.“

Chcem poprieť to, čo vidím a čítam, aby som mohol predstierať, že ľudia nepoužívajú skratky alebo sa nesnažia ušetriť peniaze používaním AI takým škodlivým spôsobom. Už len tá predstava mi je chorá. Ale nemôžem, pretože AI je stále hlúpa a zrejme aj veľa ľudí, ktorí ju chcú používať.

Možno, že myšlienka hromadného vyhynutia v dôsledku AI nie je až taká vzdialená.