Более 350 технических экспертов, исследователей искусственного интеллекта и лидеров отрасли подписали Заявление о риске ИИ опубликовано Центр безопасности ИИ на прошлой неделе. Это очень короткое и лаконичное предупреждение для всех нас:

Снижение риска исчезновения из-за ИИ должно стать глобальным приоритетом наряду с другими рисками социального масштаба, такими как пандемии и ядерная война.

Таким образом, эксперты по ИИ, в том числе инженеры-практики из Google и Microsoft, которые активно внедряют ИИ на мир, думаю, что ИИ может стать глобальным событием вымирания в том же ключе, что и ядерное война. Угу.

Признаюсь, я подумал то же самое, что и многие люди, когда они впервые прочитали это заявление — это полная ерунда. Да, у ИИ есть много проблем и я думаю, что немного рано полагаться на это так сильно, как это делают некоторые технологические и новостные компании, но такого рода гипербола просто глупа.

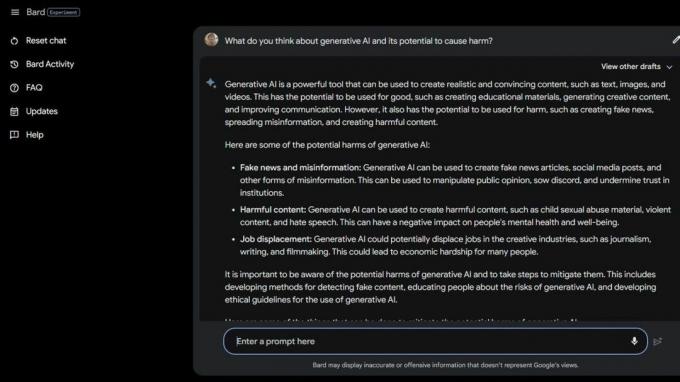

Затем я сделал несколько Бард Бета Лаборатория ИИ Поиск в Google

и обнаружил несколько причин, по которым ИИ уже вреден. Некоторые из наиболее уязвимых слоев общества подвергаются еще большему риску из-за генеративного ИИ и того, насколько на самом деле глупы эти умные компьютеры.Национальная ассоциация расстройств пищевого поведения уволили операторов горячей линии 25 мая 2023 года и заменил их чат-ботом Тессой. Рабочие находились в процессе объединения в профсоюзы, но NEDA утверждает, что «это было долгожданное изменение и что ИИ может лучше обслуживать людей с расстройствами пищевого поведения» и не имел ничего общего с шестью оплачиваемыми сотрудниками и различными добровольцами, пытающимися объединять в профсоюзы.

30 мая 2023 г., НЕДА отключенный чат-бот Тесса потому что он давал вредные советы людям с серьезными расстройствами пищевого поведения. Официально NEDA «обеспокоена и работает с технологической и исследовательской группой над дальнейшим расследованием этого; этот язык противоречит нашей политике и основным убеждениям организации по борьбе с расстройствами пищевого поведения».

В США насчитывается 30 миллионов человек с серьезными расстройствами пищевого поведения, и 10 200 человек ежегодно умирают от них. Один каждый час.

Затем у нас есть Koko, некоммерческая организация по охране психического здоровья, которая использовали ИИ в качестве эксперимента над суицидальными подростками. Да, вы правильно прочитали.

Пользователи из группы риска были перенаправлены на веб-сайт Коко из социальных сетей, где каждый был помещен в одну из двух групп. Одной группе был предоставлен номер телефона настоящей горячей линии в кризисных ситуациях, где они могли найти необходимую им помощь и поддержку.

Другая группа участвовала в эксперименте Коко, где им предстояло пройти тест, и их попросили определить, что вызывает у них мысли, и что они делают, чтобы справиться с ними.

Закончив, ИИ спросил их, будут ли они проверять свои телефонные уведомления на следующий день. Если ответ был «да», их подталкивали к экрану со словами «Спасибо за это! Вот кошка!» Конечно, там была фотография кошки, и, видимо, Коко и исследователь ИИ, которые помогли создать это, думают, что это как-то улучшит ситуацию.

Я не имею права говорить об этике подобных ситуаций, когда ИИ используется для постановки диагноза или помощи людям, борющимся с психическим здоровьем. Я эксперт по технологиям, который в основном занимается смартфоны. Однако большинство экспертов-людей согласны с тем, что эта практика изобилует проблемами. Я знаю, что неправильная «помощь» может усугубить и без того плохую ситуацию.

Если вы боретесь со своим психическим здоровьем или чувствуете, что вам нужна помощь, позвоните или напишите 988, чтобы поговорить с человеком, который может вам помочь.

Истории такого рода говорят о двух вещах: искусственный интеллект очень проблематичен, когда его используют вместо квалифицированных людей в случае кризиса, и реальные люди, которые должны знать лучше, тоже могут быть тупыми.

ИИ в его нынешнем состоянии не готов к такому использованию. Даже не близко. Профессор Вашингтонского университета Эмили М. Бендер делает большое замечание в заявление для зам.:

«Большие языковые модели — это программы для создания правдоподобно звучащего текста с учетом их обучающих данных и подсказки ввода. У них нет ни сочувствия, ни понимания языка, который они произносят, ни понимания ситуации, в которой они находятся. Но текст, который они производят, звучит правдоподобно, и поэтому люди, скорее всего, придадут ему значение. Бросить что-то подобное в деликатные ситуации — значит пойти на неизвестный риск».

Я хочу отрицать то, что я вижу и читаю, чтобы я мог притвориться, что люди не используют ярлыки и не пытаются сэкономить деньги, используя ИИ таким вредным образом. Сама идея вызывает у меня отвращение. Но я не могу, потому что ИИ все еще тупой, как и многие люди, которые хотят его использовать.

Может быть, идея массового вымирания из-за ИИ, в конце концов, не такая уж и невероятная идея.