Probabil ați auzit sau citit oameni vorbind despre IA etică. În timp ce computerele nu pot gândi de fapt și, prin urmare, nu au nicio părtinire reală sau simț al responsabilității, oamenii care dezvoltă software-ul care alimentează totul cu siguranță, și asta este ceea ce îl face important.

Nu este un lucru ușor de descris sau de observat. Asta nu înlătură nimic din cât de vital este ca marile companii tehnologice care dezvoltă produse destinate consumatorilor alimentate de AI să o facă corect. Să aruncăm o privire la ceea ce este și ce se face pentru a ne asigura că AI ne face viața mai bună și nu mai rea.

AI nu este altceva decât o bucată de software care preia ceva, îl procesează și scuipă altceva. Într-adevăr, asta face toate programele. Ceea ce face AI diferită este că ieșirea poate fi extrem de diferită de intrare.

Android și Chill

Una dintre cele mai longevive coloane de tehnologie de pe web, Android și Chill este discuția dvs. de sâmbătă despre Android, Google și toate lucrurile tehnologice.

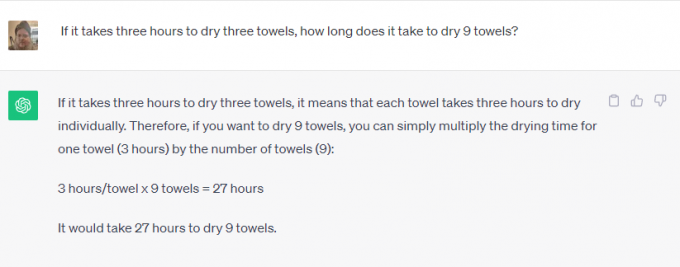

Lua ChatGPT sau Google Bard de exemplu. Puteți cere fie să rezolvați probleme de matematică, să căutați ceva pe web, să vă spuneți în ce zi a murit Elvis Presley sau să vă scrieți o scurtă poveste despre istoria bisericii catolice. Nimeni nu ar fi crezut că ai putea folosi telefonul tau pentru asta acum cativa ani.

Unele dintre acestea sunt sarcini destul de ușoare. Software-ul care este integrat cu internetul poate prelua informații despre orice și le poate regurgita înapoi ca răspuns la o interogare. Este grozav pentru că poate economisi timp, dar nu este chiar uimitor.

Unul dintre aceste lucruri este însă diferit. Software-ul este folosit pentru a crea conținut semnificativ care folosește manierele și vorbirea umană, ceea ce nu poate fi căutat pe Google. Software-ul recunoaște ceea ce cereți (scrieți-mi o poveste) și parametrii care trebuie utilizați pentru aceasta (date istorice despre biserica catolică), dar restul pare uimitor.

Credeți sau nu, dezvoltarea responsabilă contează în ambele tipuri de utilizare. Software-ul nu decide în mod magic nimic și trebuie antrenat în mod responsabil, folosind surse care sunt fie imparțiale (imposibile), fie la fel de părtinitoare din toate părțile.

Nu vrei ca Bard să folosească pe cineva care crede că Elvis este încă în viață ca singura sursă pentru ziua în care a murit. De asemenea, nu ai vrea ca cineva care urăște biserica catolică să programeze software folosit pentru a scrie o poveste despre asta. Ambele puncte de vedere trebuie luate în considerare și cântărite în raport cu alte puncte de vedere valide.

Etica contează la fel de mult ca și ținerea sub control a părtinirii umane naturale. O companie care poate dezvolta ceva trebuie să se asigure că este folosit în mod responsabil. Dacă nu poate face asta, trebuie să nu-l dezvolte deloc. Aceasta este o pantă alunecoasă - una care este mult mai greu de gestionat.

Companiile care dezvoltă software AI complicate sunt conștiente de acest lucru și crezi sau nu, în cea mai mare parte urmează regula care spune că unele lucruri pur și simplu nu ar trebui făcute chiar dacă poate sa fi făcută.

Am contactat atât Microsoft, cât și Google despre ceea ce se face pentru a mă asigura că AI este utilizat în mod responsabil. Microsoft mi-a spus că nu au nimic nou de împărtășit, dar m-a direcționat către o serie de link-uri corporative și postări pe blog despre acest subiect. citind prin ele arată că Microsoft se angajează să „asigurați-vă că sistemele AI avansate sunt sigure, securizate și demne de încredere”, în conformitate cu politica și liniile actuale din SUA standardele sale interne în mare detaliu. Microsoft are în prezent o echipă întreagă lucrează la IA responsabilă.

În schimb, Google are multe de spus în plus față de declarațiile deja publicate. Am participat recent la o prezentare despre subiect, în care angajații Google seniori au spus că singura cursă AI care contează este cursa pentru AI responsabilă. Ei au explicat că doar pentru că ceva este posibil din punct de vedere tehnic nu este un motiv suficient de bun pentru a da undă verde unui produs: dăunează trebuie identificate și atenuate ca parte a procesului de dezvoltare, astfel încât acestea să poată fi apoi utilizate pentru a o rafina în continuare proces.

Recunoașterea facială și detectarea emoțională au fost date drept exemple. Google este foarte bun la ambele și dacă nu crezi asta, aruncă o privire Google Foto unde poți căuta o anumită persoană sau oameni fericiți în propriile poze. Este, de asemenea, funcția numărul unu solicitată de potențialii clienți, dar Google refuză să o dezvolte în continuare. Prejudiciul potențial este suficient pentru ca Google să refuze să ia bani pentru el.

Și Google este în favoarea atât a reglementărilor guvernamentale, cât și a reglementărilor interne. Acest lucru este atât surprinzător, cât și important pentru că există condiții de concurență echitabile în care nicio companie nu poate crea AI dăunătoare este ceva despre care atât Google, cât și Microsoft cred că depășește orice venit potențial sau câștig financiar.

Ceea ce m-a impresionat cel mai mult a fost răspunsul Google când am întrebat despre echilibrarea acurateței și eticii. Pentru ceva precum identificarea plantelor, acuratețea este foarte importantă, în timp ce părtinirea este mai puțin importantă. Pentru ceva precum identificarea sexului cuiva într-o fotografie, ambele sunt la fel de importante. Google împarte AI în ceea ce numește felii; fiecare felie face un lucru diferit, iar rezultatul este evaluat de o echipă de oameni reali pentru a verifica rezultatele. Se fac ajustări până când echipa este mulțumită, apoi se poate întâmpla o dezvoltare ulterioară.

Nimic din toate acestea nu este perfect și cu toții am văzut AI făcând sau repetă lucruri foarte stupide, uneori chiar rănitoare. Dacă aceste prejudecăți și încălcări etice își pot găsi drumul într-un singur produs, ele pot (și fac) să își găsească drumul în toate.

Important este ca companiile care dezvoltă software-ul viitorului recunosc acest lucru și continuă să încerce să îmbunătățească procesul. Nu va fi niciodată perfect, dar atâta timp cât fiecare iterație este mai bună decât ultima, ne îndreptăm în direcția corectă.