Peste 350 de experți în tehnologie, cercetători AI și lideri din industrie au semnat Declarație privind riscul AI publicat de Centrul pentru Siguranță AI săptămâna trecută. Este un avertisment foarte scurt și succint, cu o singură propoziție, pentru noi toți:

Atenuarea riscului de dispariție din cauza IA ar trebui să fie o prioritate globală alături de alte riscuri la scară societală, cum ar fi pandemiile și războiul nuclear.

Așadar, experții AI, inclusiv inginerii de la Google și Microsoft, care lansează activ AI asupra lumii, credeți că AI are potențialul de a fi un eveniment de extincție globală în aceeași ordine de idei cu nuclearul război. Da.

Recunosc că am crezut același lucru pe care l-au făcut mulți oameni când au citit pentru prima dată această declarație - asta e o grămadă de rahat. Da AI are multe probleme și cred că este puțin devreme să ne sprijinim pe el la fel de mult cum fac unele companii de tehnologie și de știri, dar acest tip de hiperbolă este pur și simplu o prostie.

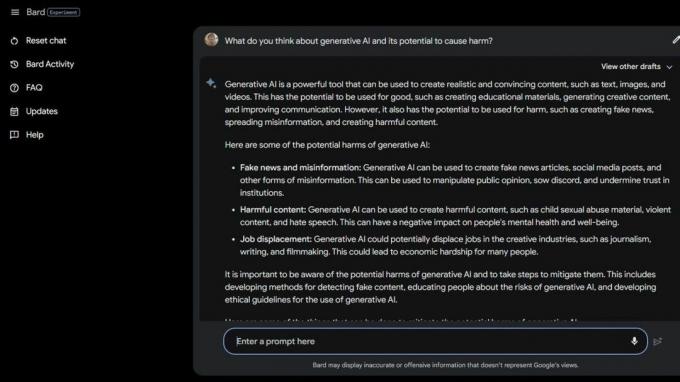

Apoi am făcut câteva Bard Beta Lab AI Google și a găsit mai multe moduri în care AI este deja dăunătoare. Unii dintre cei mai vulnerabili din societate sunt și mai expuși riscului din cauza inteligenței artificiale generative și a cât de stupide sunt de fapt aceste computere inteligente.

Asociația Națională a Tulburărilor Alimentare și-a concediat operatorii liniilor de asistență pe 25 mai 2023 și le-a înlocuit cu Tessa, ChatBot. Lucrătorii se aflau în plin proces de sindicalizare, dar NEDA susține că „aceasta a fost o schimbare așteptată de mult și că AI poate îmbunătăți servi pe cei cu tulburări de alimentație” și nu a avut nimic de-a face cu șase angajați plătiți și voluntari care încercau să se sindicaliza.

La 30 mai 2023, NEDA a dezactivat Tessa ChatBot deoarece oferea sfaturi dăunătoare persoanelor cu tulburări grave de alimentație. Oficial, NEDA este „îngrijorată și lucrează cu echipa de tehnologie și echipa de cercetare pentru a investiga acest lucru în continuare; acel limbaj este împotriva politicilor și convingerilor noastre fundamentale ca organizație pentru tulburări de alimentație.”

În SUA există 30 de milioane de oameni cu tulburări grave de alimentație și 10.200 vor muri în fiecare an ca urmare directă a acestora. Una la fiecare oră.

Apoi avem Koko, o organizație nonprofit de sănătate mintală care a folosit AI ca un experiment pe adolescenți sinucigași. Da, ai citit bine.

Utilizatorii cu risc au fost direcționați către site-ul web al lui Koko de pe rețelele sociale, unde fiecare a fost plasat într-unul din cele două grupuri. Unui grup i s-a oferit un număr de telefon la o linie telefonică de criză reală, unde speră că ar putea găsi ajutorul și sprijinul de care aveau nevoie.

Celălalt grup a primit experimentul lui Koko în care au ajuns să susțină un test și au fost rugați să identifice lucrurile care le-au declanșat gândurile și ce făceau pentru a le face față.

Odată terminat, AI i-a întrebat dacă își vor verifica notificările de pe telefon a doua zi. Dacă răspunsul a fost da, au fost împinși pe un ecran spunând „Mulțumesc pentru asta! Iată o pisică!” Desigur, a existat o imagine a unei pisici și, se pare, Koko și cercetătorul AI care au ajutat la crearea acestui gând care va îmbunătăți cumva lucrurile.

Nu sunt calificat să vorbesc despre etica unor situații ca aceasta în care AI este folosită pentru a oferi diagnostic sau ajutor pentru oamenii care se luptă cu sănătatea mintală. Sunt un expert în tehnologie care se concentrează în mare parte pe smartphone-uri. Majoritatea experților umani sunt de acord că practica este plină de probleme, totuși. Știu că tipul greșit de „ajutor” poate și va înrăutăți cu mult o situație proastă.

Dacă vă confruntați cu sănătatea mintală sau simțiți că aveți nevoie de ajutor, sunați sau trimiteți un mesaj la 988 pentru a vorbi cu un om care vă poate ajuta.

Aceste tipuri de povești spun două lucruri – AI este foarte problematică atunci când este folosită în locul persoanelor calificate în caz de criză, iar oamenii adevărați care ar trebui să cunoască mai bine pot fi și proști.

AI în starea sa actuală nu este pregătită pentru a fi utilizată în acest fel. Nici măcar pe aproape. Profesorul de la Universitatea din Washington, Emily M. Bender face un punct grozav o declarație către Vice:

„Modelele de limbaj mari sunt programe pentru generarea de text cu sunet plauzibil, având în vedere datele de antrenament și un prompt de introducere. Ei nu au empatie, nici o înțelegere a limbajului pe care o produc, nici o înțelegere a situației în care se află. Dar textul pe care îl produc sună plauzibil și, astfel, este posibil ca oamenii să-i atribuie un sens. A arunca așa ceva în situații sensibile înseamnă a-ți asumi riscuri necunoscute.”

Vreau să neg ceea ce văd și citesc, astfel încât să mă pot preface că oamenii nu iau scurtături sau nu încearcă să economisească bani folosind AI în moduri atât de dăunătoare. Însăși ideea mă îngrozește. Dar nu pot pentru că AI este încă prost și, aparent, la fel sunt mulți dintre cei care doresc să o folosească.

Poate că ideea unui eveniment de extincție în masă din cauza inteligenței artificiale nu este o idee atât de îndepărtată până la urmă.