Você provavelmente já ouviu ou leu pessoas falando sobre IA ética. Embora os computadores não possam realmente pensar e, portanto, não tenham preconceito ou senso de responsabilidade, as pessoas que desenvolvem o software que alimenta tudo isso certamente o fazem e é isso que o torna importante.

Não é algo fácil de descrever ou notar. Isso não diminui em nada o quão vital é que as grandes empresas de tecnologia que desenvolvem produtos voltados para o consumidor alimentados por IA façam o que é certo. Vamos dar uma olhada no que é e no que está sendo feito para garantir que a IA torne nossas vidas melhores em vez de piores.

A IA nada mais é do que um pedaço de software que pega algo, processa e cospe outra coisa. Na verdade, é isso que todo software faz. O que torna a IA diferente é que a saída pode ser totalmente diferente da entrada.

Android e relaxamento

Uma das colunas de tecnologia mais antigas da web, Android e relaxamento é a sua discussão de sábado sobre Android, Google e todas as coisas relacionadas à tecnologia.

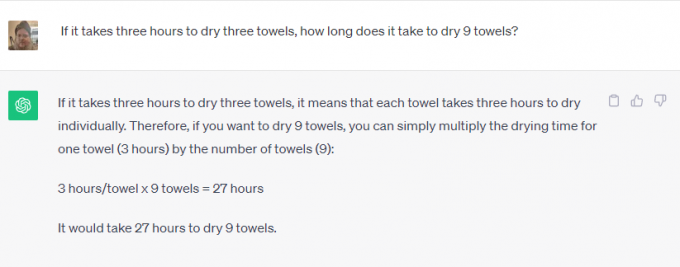

Pegar Bate-papoGPT ou Google Bardo por exemplo. Você pode pedir para resolver problemas de matemática, procurar algo na web, dizer em que dia Elvis Presley morreu ou escrever um conto sobre a história da Igreja Católica. Ninguém teria pensado que você poderia usar seu telefone para isso há alguns anos.

Algumas dessas são tarefas muito fáceis. O software integrado à Internet pode buscar informações sobre qualquer coisa e regurgitá-las como resposta a uma consulta. É ótimo porque pode economizar tempo, mas não é realmente incrível.

Uma dessas coisas é diferente, no entanto. O software é usado para criar conteúdo significativo que usa maneirismos e fala humanos, o que não é algo que pode ser pesquisado no Google. O software reconhece o que você está pedindo (escreva-me uma história) e os parâmetros a serem utilizados para isso (dados históricos sobre a Igreja Católica), mas o resto parece incrível.

Acredite ou não, o desenvolvimento responsável é importante em ambos os tipos de uso. O software não decide nada magicamente e deve ser treinado de forma responsável, usando fontes imparciais (impossíveis) ou igualmente tendenciosas de todos os lados.

Você não quer que Bard use alguém que pensa que Elvis ainda está vivo como a única fonte do dia em que morreu. Você também não gostaria que alguém que odeia a Igreja Católica programasse um software usado para escrever uma história sobre ela. Ambos os pontos de vista precisam ser considerados e ponderados contra outros pontos de vista válidos.

A ética é tão importante quanto manter o preconceito humano natural sob controle. Uma empresa que pode desenvolver algo precisa garantir que seja usado de forma responsável. Se não puder fazer isso, não precisa desenvolvê-lo. Essa é uma ladeira escorregadia – muito mais difícil de administrar.

As empresas que desenvolvem softwares complexos de IA estão cientes disso e, acreditem ou não, em sua maioria seguem a regra que diz que algumas coisas simplesmente não deveriam ser feitas, mesmo que sejam pode ser feito.

Entrei em contato com a Microsoft e o Google para saber o que está sendo feito para garantir que a IA seja usada de maneira responsável. A Microsoft me disse que não tinha nada de novo para compartilhar, mas me direcionou para uma série de links corporativos e postagens em blogs sobre o assunto. lê-los mostra que a Microsoft está comprometido com "garantir que os sistemas avançados de IA sejam seguros, protegidos e confiáveis" de acordo com a política e os contornos atuais dos EUA seus padrões internos Em grande detalhe. A Microsoft atualmente tem uma equipe inteira trabalhando em IA responsável.

Em contraste, o Google tem muito a dizer além das declarações já publicadas. Recentemente assisti a uma apresentação sobre o assunto, onde funcionários seniores do Google disseram que a única corrida pela IA que importa é a corrida pela IA responsável. Eles explicaram que só porque algo é tecnicamente possível não é razão suficiente para dar luz verde a um produto: prejudica precisam ser identificados e mitigados como parte do processo de desenvolvimento para que possam então ser usados para refinar ainda mais esse processo.

O reconhecimento facial e a detecção emocional foram dados como exemplos. O Google é muito bom em ambos e se você não acredita nisso, dê uma olhada em Google Fotos onde você pode procurar uma pessoa específica ou pessoas felizes em suas próprias fotos. É também o recurso número um solicitado por clientes em potencial, mas o Google se recusa a desenvolvê-lo ainda mais. O dano potencial é suficiente para que o Google se recuse a aceitar dinheiro por isso.

O Google também é a favor tanto da regulamentação governamental quanto da regulamentação interna. Isso é surpreendente e importante porque condições equitativas onde nenhuma empresa pode criar IA prejudicial é algo que tanto o Google quanto a Microsoft consideram que supera qualquer receita potencial ou ganho financeiro.

O que mais me impressionou foi a resposta do Google quando perguntei sobre o equilíbrio entre precisão e ética. Para algo como a identificação de plantas, a precisão é muito importante, enquanto o preconceito é menos importante. Para algo como identificar o sexo de alguém em uma foto, ambos são igualmente importantes. O Google divide a IA no que chama de fatias; cada fatia faz uma coisa diferente e o resultado é avaliado por uma equipe de pessoas reais para verificar os resultados. Os ajustes são feitos até que a equipe esteja satisfeita, então um maior desenvolvimento pode acontecer.

Nada disso é perfeito e todos nós vimos a IA fazer ou repetir coisas muito estúpidas, às vezes até coisas prejudiciais. Se esses preconceitos e violações éticas conseguem chegar a um produto, eles podem (e conseguem) chegar a todos eles.

O importante é que as empresas que desenvolvem o software do futuro reconheçam isso e continuem tentando melhorar o processo. Nunca será perfeito, mas desde que cada iteração seja melhor que a anterior, estaremos caminhando na direção certa.