Du har sikkert hørt eller lest folk som snakker om etisk kunstig intelligens. Mens datamaskiner faktisk ikke kan tenke og dermed ikke har noen faktisk skjevhet eller ansvarsfølelse, gjør de som utvikler programvaren som driver det hele, og det er det som gjør det viktig.

Det er ikke lett å beskrive eller legge merke til. Det tar ikke noe fra hvor viktig det er at store teknologiselskaper som utvikler forbrukerrettede produkter drevet av AI gjør det riktig. La oss ta en titt på hva det er og hva som gjøres for å sikre at AI gjør livene våre bedre i stedet for verre.

AI er ikke noe mer enn en del av programvare som tar inn noe, behandler det og spytter ut noe annet. Det er egentlig det all programvare gjør. Det som gjør AI forskjellig er at utgangen kan være veldig forskjellig fra inngangen.

Android og Chill

En av nettets lengste teknologikolonner, Android og Chill er lørdagsdiskusjonen din om Android, Google og alt som er teknisk.

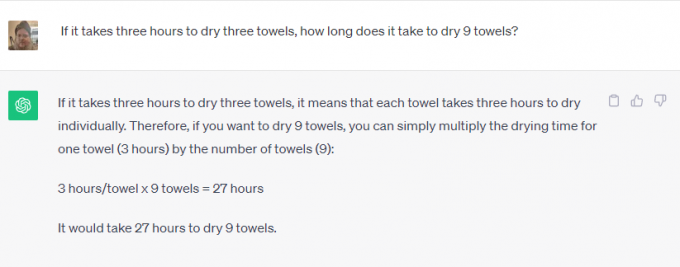

Ta ChatGPT eller Google Bard for eksempel. Du kan enten be om å løse matematiske problemer, slå opp noe på nettet, fortelle deg hvilken dag Elvis Presley døde, eller skrive deg en novelle om historien til den katolske kirken. Ingen ville trodd du kunne bruke

din telefon for dette for noen år siden.Noen av disse er ganske enkle oppgaver. Programvare som er integrert med internett kan hente informasjon om hva som helst og sette den tilbake som et svar på et spørsmål. Det er flott fordi det kan spare tid, men det er egentlig ikke fantastisk.

En av disse tingene er imidlertid annerledes. Programvare brukes til å lage meningsfylt innhold som bruker menneskelig væremåte og tale, som ikke er noe som kan slås opp på Google. Programvaren gjenkjenner det du spør om (skriv meg en historie) og parametrene som skal brukes for det (historiske data om den katolske kirken), men resten virker fantastisk.

Tro det eller ei, ansvarlig utvikling er viktig for begge typer bruk. Programvare bestemmer ikke noe på magisk vis, og den må trenes ansvarlig, ved å bruke kilder som enten er objektive (umulige) eller like partiske fra alle sider.

Du vil ikke at Bard skal bruke noen som tror Elvis fortsatt er i live som den eneste kilden til dagen han døde. Du vil heller ikke at noen som hater den katolske kirken skal programmere programvare som brukes til å skrive en historie om den. Begge synspunkter må vurderes og veies opp mot andre gyldige synspunkter.

Etikk betyr like mye som å holde naturlig menneskelig skjevhet i sjakk. En bedrift som kan utvikle noe, må sørge for at det brukes på en ansvarlig måte. Hvis den ikke kan gjøre det, må den ikke utvikle den i det hele tatt. Det er en glatt skråning - en som er mye vanskeligere å håndtere.

Selskapene som utvikler intrikat AI-programvare er klar over dette og tro det eller ei, følger for det meste regelen som sier at noen ting bare ikke bør lages selv om de kan bli laget.

Jeg tok kontakt med både Microsoft og Google om hva som gjøres for å sikre at AI brukes på en ansvarlig måte. Microsoft fortalte meg at de ikke hadde noe nytt å dele, men henviste meg til en rekke firmalenker og blogginnlegg om emnet. lesing gjennom dem viser at Microsoft er forpliktet til "sikre at avanserte AI-systemer er trygge, sikre og pålitelige" i samsvar med gjeldende amerikanske retningslinjer og skisser sine interne standarder i stor detalj. Microsoft har for tiden et helt team jobber med ansvarlig AI.

Derimot har Google mye å si i tillegg til sine allerede publiserte uttalelser. Jeg deltok nylig på en presentasjon om emnet der senior Google-ansatte sa at det eneste AI-løpet som betyr noe er kappløpet om ansvarlig AI. De forklarte at bare fordi noe er teknisk mulig, er det ikke en god nok grunn til å lyse opp et produkt: skader må identifiseres og reduseres som en del av utviklingsprosessen, slik at de deretter kan brukes til å avgrense det ytterligere prosess.

Ansiktsgjenkjenning og emosjonell gjenkjenning ble gitt som eksempler. Google er veldig gode på begge deler, og hvis du ikke tror det, ta en titt på Google Foto hvor du kan søke etter en bestemt person eller etter glade mennesker i dine egne bilder. Det er også nummer én-funksjonen etterspurt av potensielle kunder, men Google nekter å utvikle den videre. Den potensielle skaden er nok til at Google nekter å ta penger for det.

Google er også for både statlig regulering og intern regulering. Det er både overraskende og viktig fordi det er like konkurransevilkår der ingen bedrift kan skape skadelig AI er noe som både Google og Microsoft mener oppveier enhver potensiell inntekt eller økonomisk gevinst.

Det som imponerte meg mest var Googles svar da jeg spurte om balansering av nøyaktighet og etikk. For noe som planteidentifikasjon er nøyaktighet veldig viktig mens skjevhet er mindre viktig. For noe som å identifisere noens kjønn på et bilde, er begge like viktige. Google bryter AI inn i det den kaller skiver; hver skive gjør en annen ting, og resultatet blir evaluert av et team av ekte mennesker for å sjekke resultatene. Justeringer gjøres til teamet er fornøyd, så kan videre utvikling skje.

Ingenting av dette er perfekt, og vi har alle sett AI gjøre eller gjenta veldig dumme ting, noen ganger til og med sårende ting. Hvis disse skjevhetene og etiske bruddene kan finne veien inn i ett produkt, kan (og gjør) de finne veien inn i dem alle.

Det som er viktig er at selskapene som utvikler fremtidens programvare anerkjenner dette og fortsetter å prøve å forbedre prosessen. Det vil aldri bli perfekt, men så lenge hver iterasjon er bedre enn den forrige, beveger vi oss i riktig retning.