Over 350 teknologieksperter, AI-forskere og industriledere signerte avtalen Uttalelse om AI-risiko utgitt av Senter for AI-sikkerhet denne siste uken. Det er en veldig kort og konsist advarsel for oss alle:

Å redusere risikoen for utryddelse fra AI bør være en global prioritet sammen med andre samfunnsmessige risikoer som pandemier og atomkrig.

Så AI-ekspertene, inkludert praktiske ingeniører fra Google og Microsoft som aktivt slipper løs AI på verden, tror AI har potensial til å være en global utryddelseshendelse på samme måte som kjernefysisk krig. Jepp.

Jeg skal innrømme at jeg tenkte det samme som mange mennesker gjorde da de leste denne uttalelsen for første gang - det er en mengde hesteskit. Ja AI har mange problemer og jeg synes det er litt tidlig å lene seg like mye på det som noen teknologi- og nyhetsselskaper gjør, men den slags overdrivelse er bare dumt.

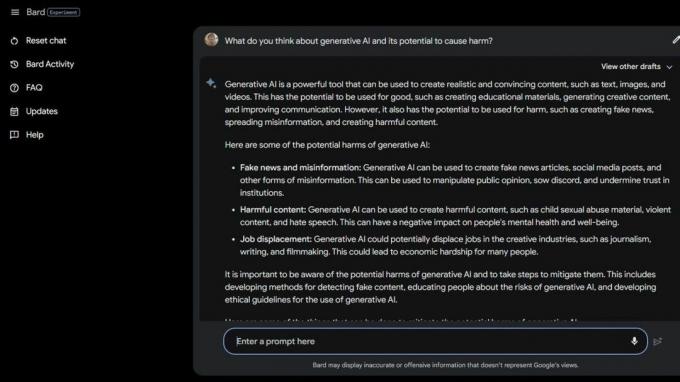

Så gjorde jeg noen Bard Beta Lab AI Googling og fant flere måter AI allerede er skadelig på. Noen av samfunnets mest sårbare er enda mer utsatt på grunn av generativ AI og hvor dumme disse smarte datamaskinene faktisk er.

The National Eating Disorders Association sparket sine hjelpelinjeoperatører 25. mai 2023, og erstattet dem med Tessa the ChatBot. Arbeiderne var midt i fagforening, men NEDA hevder "dette var en lenge forventet endring og at AI kan bedre betjene de med spiseforstyrrelser" og hadde ingenting å gjøre med seks betalte ansatte og diverse frivillige som prøvde å fagforening.

30. mai 2023, NEDA deaktiverte ChatBot Tessa fordi den ga skadelige råd til personer med alvorlige spiseforstyrrelser. Offisielt er NEDA "bekymret og jobber med teknologiteamet og forskningsteamet for å undersøke dette videre; at språk er i strid med vår politikk og kjerneoppfatning som en spiseforstyrrelsesorganisasjon."

I USA er det 30 millioner mennesker med alvorlige spiseforstyrrelser og 10 200 vil dø hvert år som en direkte følge av dem. En hver time.

Så har vi Koko, en ideell organisasjon for mental helse som brukte AI som et eksperiment på selvmordstruede tenåringer. Ja, du leste riktig.

Risikobrukere ble ledet til Kokos nettsted fra sosiale medier hvor hver ble plassert i en av to grupper. En gruppe fikk et telefonnummer til en faktisk krisetelefon der de forhåpentligvis kunne finne den hjelpen og støtten de trengte.

Den andre gruppen fikk Kokos eksperiment der de fikk ta en quiz og ble bedt om å identifisere tingene som trigget tankene deres og hva de gjorde for å takle dem.

Når de var ferdige, spurte AI dem om de ville sjekke telefonvarslene deres neste dag. Hvis svaret var ja, ble de dyttet til en skjerm som sa "Takk for det! Her er en katt!" Selvfølgelig var det et bilde av en katt, og tilsynelatende tenker Koko og AI-forskeren som hjalp til med å skape denne tanken som vil gjøre ting bedre på en eller annen måte.

Jeg er ikke kvalifisert til å snakke om etikken i situasjoner som dette der AI brukes til å gi diagnose eller hjelp til folk som sliter med mental helse. Jeg er en teknologiekspert som stort sett fokuserer på smarttelefoner. De fleste menneskelige eksperter er enige om at praksisen er full av problemer. Jeg vet at feil type "hjelp" kan og vil gjøre en dårlig situasjon langt verre.

Hvis du sliter med din mentale helse eller føler at du trenger hjelp, kan du ringe eller sende en sms til 988 for å snakke med et menneske som kan hjelpe deg.

Slike historier forteller to ting - AI er veldig problematisk når det brukes i stedet for kvalifiserte personer i tilfelle en krise, og ekte mennesker som skal vite bedre kan også være dumme.

AI i sin nåværende tilstand er ikke klar til å brukes på denne måten. Ikke engang i nærheten. University of Washington professor Emily M. Bender gjør et godt poeng en uttalelse til Vice:

"Store språkmodeller er programmer for å generere plausibelt klingende tekst gitt treningsdataene deres og en inndatamelding. De har ikke empati, eller noen forståelse for språket de produserer, eller noen forståelse for situasjonen de er i. Men teksten de produserer høres plausibel ut, og derfor vil folk sannsynligvis gi den mening. Å kaste noe sånt inn i sensitive situasjoner er å ta ukjente risikoer."

Jeg vil benekte det jeg ser og leser, slik at jeg kan late som om folk ikke tar snarveier eller prøver å spare penger ved å bruke AI på måter som er så skadelige. Selve ideen er kvalmende for meg. Men jeg kan ikke fordi AI fortsatt er dum, og tilsynelatende er det mange som vil bruke det.

Kanskje ideen om en masseutryddelseshendelse på grunn av AI ikke er en så fjern idé likevel.