Jūs droši vien esat dzirdējis vai lasījis cilvēkus runājam par ētisku AI. Lai gan datori faktiski nevar domāt un tādējādi tiem nav faktiskas aizspriedumu vai atbildības sajūtas, cilvēki, kas izstrādā programmatūru, kas to visu nodrošina, to noteikti dara, un tieši tāpēc tas ir svarīgi.

To nav viegli aprakstīt vai pamanīt. Tas neko neatņem no tā, cik svarīgi ir, lai lielie tehnoloģiju uzņēmumi, kas izstrādā patērētājiem paredzētus produktus, kurus darbina AI, darītu to pareizi. Apskatīsim, kas tas ir un kas tiek darīts, lai AI padarītu mūsu dzīvi labāku, nevis sliktāku.

AI ir nekas vairāk kā programmatūras gabals, kas kaut ko uzņem, apstrādā un izspiež kaut ko citu. Patiešām, to dara visa programmatūra. AI atšķiras ar to, ka izvade var ievērojami atšķirties no ievades.

Android un Chill

Viena no tīmekļa visilgāk strādājošajām tehnoloģiju slejām, Android un Chill ir jūsu sestdienas diskusija par Android, Google un visām tehnoloģijām.

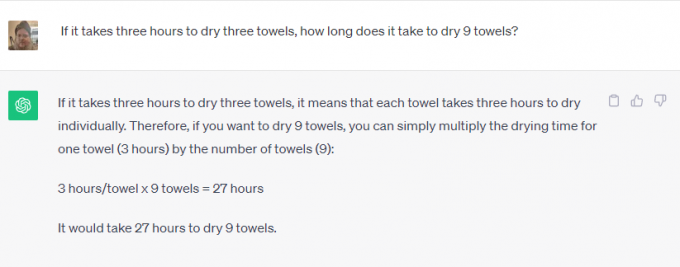

Ņem ChatGPT vai Google Bard piemēram. Varat lūgt atrisināt matemātikas uzdevumus, meklēt kaut ko tīmeklī, pastāstīt, kurā dienā nomira Elviss Preslijs, vai uzrakstīt īsu stāstu par katoļu baznīcas vēsturi. Neviens nebūtu domājis, ka varat to izmantot

Tavs telefons par to pirms dažiem gadiem.Daži no tiem ir diezgan viegli uzdevumi. Programmatūra, kas ir integrēta ar internetu, var iegūt informāciju par jebko un atgūt to kā atbildi uz vaicājumu. Tas ir lieliski, jo tas var ietaupīt laiku, bet tas nav īsti pārsteidzošs.

Tomēr viena no šīm lietām ir atšķirīga. Programmatūra tiek izmantota, lai izveidotu jēgpilnu saturu, kurā izmantotas cilvēka manieres un runa, ko nevar meklēt Google tīklā. Programmatūra atpazīst jūsu jautāto (uzrakstiet man stāstu) un tam izmantojamos parametrus (vēsturiskos datus par katoļu baznīcu), bet pārējais šķiet pārsteidzošs.

Ticiet vai nē, bet atbildīga attīstība ir svarīga abos lietošanas veidos. Programmatūra maģiski neizšķir neko, un tā ir jāapmāca atbildīgi, izmantojot avotus, kas ir vai nu objektīvi (neiespējami), vai vienādi neobjektīvi no visām pusēm.

Jūs nevēlaties, lai Bārds izmantotu kādu, kurš domā, ka Elviss joprojām ir dzīvs, kā vienīgo nāves dienas avotu. Jūs arī nevēlaties, lai kāds, kurš ienīst katoļu baznīcu, programmētu programmatūru, ko izmanto, lai par to uzrakstītu stāstu. Abi viedokļi ir jāapsver un jāsalīdzina ar citiem pamatotiem viedokļiem.

Ētikai ir tikpat liela nozīme kā cilvēka dabiskās aizsprieduma kontrolei. Uzņēmumam, kas var kaut ko izstrādāt, ir jāpārliecinās, ka tas tiek izmantots atbildīgi. Ja tas to nevar izdarīt, tas vispār nav jāattīsta. Tā ir slidena nogāze, kuru ir daudz grūtāk pārvaldīt.

Uzņēmumi, kas izstrādā sarežģītu AI programmatūru, to apzinās un, ticiet vai nē, lielākoties ievēro likumu, ka dažas lietas vienkārši nevajadzētu veikt, pat ja tās var jātaisa.

Es sazinājos gan ar Microsoft, gan Google par to, kas tiek darīts, lai nodrošinātu, ka mākslīgais intelekts tiek izmantots atbildīgi. Microsoft man teica, ka viņiem nav nekā jauna, ar ko dalīties, bet novirzīja mani uz vairākām korporatīvajām saitēm un emuāra ierakstiem par šo tēmu. lasot tos, redzams, ka Microsoft ir apņēmusies "nodrošināt, ka uzlabotās AI sistēmas ir drošas, drošas un uzticamas" saskaņā ar pašreizējo ASV politiku un izklāstiem tās iekšējie standarti ļoti detalizēti. Microsoft pašlaik ir visa komanda strādājot pie atbildīga AI.

Turpretim Google ir daudz ko teikt papildus jau publicētajiem paziņojumiem. Es nesen apmeklēju prezentāciju par šo tēmu, kurā vecākie Google darbinieki teica, ka vienīgā AI sacīkste, kurai ir nozīme, ir sacīkstes par atbildīgu AI. Viņi paskaidroja, ka tikai tāpēc, ka kaut kas ir tehniski iespējams, tas nav pietiekami labs iemesls, lai izgaismotu produktu: kaitējums ir jāidentificē un jāmazina kā daļa no izstrādes procesa, lai pēc tam tos varētu izmantot tālākai uzlabošanai process.

Kā piemēri tika dota sejas atpazīšana un emociju noteikšana. Google ir ļoti labs abos gadījumos, un, ja neticat, apskatiet Google fotoattēli kur varat meklēt konkrētu personu vai laimīgus cilvēkus savos attēlos. Tā ir arī potenciālo klientu pieprasītā funkcija numur viens, taču Google atsakās to attīstīt tālāk. Iespējamā kaitējuma pietiek, lai Google atteiktos par to ņemt naudu.

Arī Google atbalsta gan valsts regulējumu, gan iekšējo regulējumu. Tas ir gan pārsteidzoši, gan svarīgi, jo līdzvērtīgus konkurences apstākļus nevar izveidot neviens uzņēmums kaitīgais AI ir kaut kas tāds, ko gan Google, gan Microsoft uzskata, ka tas atsver visus iespējamos ienākumus vai finansiāls ieguvums.

Mani visvairāk pārsteidza Google atbilde, kad jautāju par precizitātes un ētikas līdzsvarošanu. Piemēram, augu identificēšanai precizitāte ir ļoti svarīga, savukārt neobjektivitāte ir mazāk svarīga. Piemēram, lai noteiktu personas dzimumu fotoattēlā, abi ir vienlīdz svarīgi. Google sadala AI tā sauktajās šķēlēs; katra šķēle dara citu, un rezultātu novērtē reālu cilvēku komanda, lai pārbaudītu rezultātus. Tiek veiktas korekcijas, līdz komanda ir apmierināta, tad var notikt tālāka attīstība.

Nekas no tā nav ideāls, un mēs visi esam redzējuši, ka AI dara vai atkārto ļoti muļķīgas lietas, dažreiz pat kaitīgas lietas. Ja šie aizspriedumi un ētikas pārkāpumi var nonākt vienā produktā, tie var (un to dara) visos tajos.

Svarīgi ir tas, ka uzņēmumi, kas izstrādā nākotnes programmatūru, to atzīst un turpina censties uzlabot procesu. Tas nekad nebūs ideāls, taču, kamēr katra iterācija ir labāka par iepriekšējo, mēs virzāmies pareizajā virzienā.