Vairāk nekā 350 tehnoloģiju eksperti, AI pētnieki un nozares līderi parakstīja līgumu Paziņojums par AI risku publicēja AI drošības centrs pagājušajā nedēļā. Tas ir ļoti īss un kodolīgs viena teikuma brīdinājums mums visiem:

AI izraisītā izzušanas riska mazināšanai ir jābūt globālai prioritātei līdzās citiem sabiedrības mēroga riskiem, piemēram, pandēmijām un kodolkaram.

Tātad AI eksperti, tostarp praktiski inženieri no Google un Microsoft, kuri aktīvi atbrīvo AI uz pasaules uzskatu, ka AI var būt globāls izmiršanas notikums tādā pašā veidā kā kodolenerģija karš. Jā.

Atzīšos, es domāju to pašu, ko daudzi cilvēki darīja, kad viņi pirmo reizi izlasīja šo paziņojumu — tā ir zirgu sūda. Jā AI ir daudz problēmu un es domāju, ka ir mazliet pāragri uz to paļauties, kā to dara daži tehnoloģiju un ziņu uzņēmumi, taču šāda hiperbola ir vienkārši muļķīga.

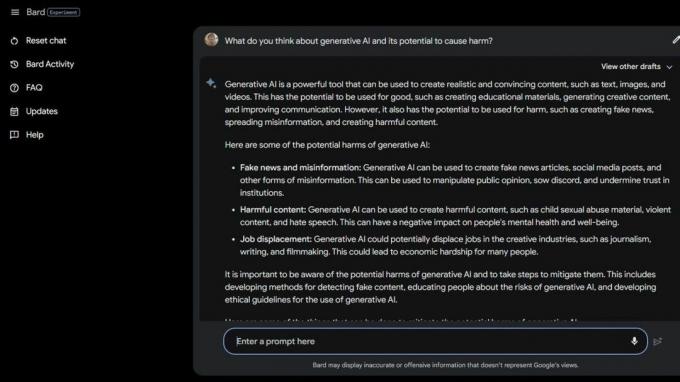

Tad es izdarīju dažus Bard Beta Lab AI Google meklēšana un atklāja vairākus veidus, kā AI jau ir kaitīgs. Daži no sabiedrības visneaizsargātākajiem ir vēl vairāk apdraudēti ģeneratīvā AI un to, cik stulbi šie viedie datori patiesībā ir, dēļ.

Nacionālā ēšanas traucējumu asociācija atlaida palīdzības tālruņa operatorus 2023. gada 25. maijā un aizstāja tos ar Tesu tērzēšanas robotu. Darba ņēmēji bija arodbiedrību vidū, taču NEDA apgalvo, ka "šīs bija ilgi gaidītas pārmaiņas un AI var labāk apkalpot tos, kuriem ir ēšanas traucējumi”, un tam nebija nekāda sakara ar sešiem algotiem darbiniekiem un dažādiem brīvprātīgajiem apvienoties arodbiedrībās.

2023. gada 30. maijā NEDA atspējoja Tesu tērzēšanas robotu jo tas piedāvāja kaitīgus padomus cilvēkiem ar nopietniem ēšanas traucējumiem. Oficiāli NEDA ir "noraizējusies un sadarbojas ar tehnoloģiju komandu un pētniecības grupu, lai to turpinātu izmeklēt; šī valoda ir pretrunā mūsu kā ēšanas traucējumu organizācijas politikai un galvenajiem uzskatiem."

ASV ir 30 miljoni cilvēku ar nopietniem ēšanas traucējumiem, un katru gadu 10 200 mirs tieši to dēļ. Viens katru stundu.

Tad mums ir Koko, garīgās veselības bezpeļņas organizācija izmantoja AI kā eksperimentu ar pašnāvnieciskiem pusaudžiem. Jā, jūs izlasījāt pareizi.

Riska grupas lietotāji no sociālajiem medijiem tika novirzīti uz Koko vietni, kur katrs tika ievietots vienā no divām grupām. Vienai grupai tika piešķirts tālruņa numurs faktiskajai krīzes palīdzības līnijai, kur viņi, cerams, varētu atrast vajadzīgo palīdzību un atbalstu.

Otra grupa ieguva Koko eksperimentu, kurā viņiem bija jāizpilda viktorīna, un viņiem tika lūgts noteikt lietas, kas izraisīja viņu domas, un to, ko viņi dara, lai ar tām tiktu galā.

Kad tas bija pabeigts, AI jautāja, vai viņi nākamajā dienā pārbaudīs tālruņa paziņojumus. Ja atbilde bija jā, viņi tika piespiesti pie ekrāna ar uzrakstu "Paldies par to! Šeit ir kaķis!" Protams, bija kaķa attēls, un acīmredzot Koko un mākslīgā intelekta pētnieks, kurš palīdzēja radīt šo domu, kaut kā uzlabos lietas.

Es neesmu kvalificēts runāt par ētiku tādās situācijās kā šī, kad mākslīgais intelekts tiek izmantots, lai nodrošinātu diagnozi vai palīdzību cilvēkiem, kuri cīnās ar garīgo veselību. Esmu tehnoloģiju eksperts, kurš galvenokārt koncentrējas uz viedtālruņi. Tomēr lielākā daļa cilvēku ekspertu piekrīt, ka praksē ir daudz problēmu. Es zinu, ka nepareiza veida "palīdzība" var padarīt sliktu situāciju daudz sliktāku.

Ja jums ir problēmas ar savu garīgo veselību vai jūtat, ka jums nepieciešama palīdzība, lūdzu, zvaniet vai rakstiet īsziņu uz numuru 988, lai runātu ar cilvēku, kurš var jums palīdzēt.

Šāda veida stāsti stāsta par divām lietām — AI ir ļoti problemātiska, ja krīzes gadījumā to izmanto kvalificētu cilvēku vietā, un arī īsti cilvēki, kuriem vajadzētu zināt labāk, var būt mēmi.

AI pašreizējā stāvoklī nav gatavs lietošanai šādā veidā. Pat ne tuvu. Vašingtonas Universitātes profesore Emīlija M. Benders lieliski norāda paziņojumu Vicei:

"Lielie valodu modeļi ir programmas ticami skanoša teksta ģenerēšanai, ņemot vērā to apmācības datus un ievades uzvedni. Viņiem nav ne empātijas, ne izpratnes par valodu, ko viņi ražo, ne arī izpratnes par situāciju, kurā viņi atrodas. Taču viņu radītais teksts izklausās ticams, un tāpēc cilvēki, visticamāk, piešķirs tam nozīmi. Kaut ko tādu iemest jutīgās situācijās nozīmē uzņemties nezināmu risku."

Es vēlos noliegt to, ko redzu un lasu, lai varētu izlikties, ka cilvēki neizmanto īsceļus vai nemēģina ietaupīt naudu, izmantojot AI tik kaitīgos veidos. Pati ideja man ir nepatīkama. Bet es nevaru, jo AI joprojām ir mēms, un acīmredzot arī daudzi cilvēki, kas vēlas to izmantot.

Varbūt ideja par masveida izzušanu mākslīgā intelekta dēļ tomēr nav tik tāla ideja.