Tikriausiai girdėjote ar skaitėte žmones kalbant apie etišką AI. Nors kompiuteriai iš tikrųjų negali mąstyti ir dėl to neturi tikro šališkumo ar atsakomybės jausmo, žmonės, kuriantys visa tai užtikrinančią programinę įrangą, tikrai tai daro, ir todėl tai yra svarbu.

Tai nėra lengva apibūdinti ar pastebėti. Tai nieko neatima nuo to, kaip labai svarbu, kad didelės technologijų įmonės, kuriančios vartotojams skirtus produktus, varomus dirbtinio intelekto, darytų tai teisingai. Pažiūrėkime, kas tai yra ir kas daroma, kad AI pagerintų mūsų gyvenimą, o ne blogintų.

AI yra ne kas kita, kaip programinės įrangos gabalas, kuris ką nors priima, apdoroja ir išspjauna kažką kita. Tikrai taip daro visa programinė įranga. AI skiriasi tuo, kad išvestis gali labai skirtis nuo įvesties.

Android ir Chill

Viena iš ilgiausiai veikiančių technologijų stulpelių, Android ir Chill yra jūsų šeštadienio diskusija apie „Android“, „Google“ ir visas technologijas.

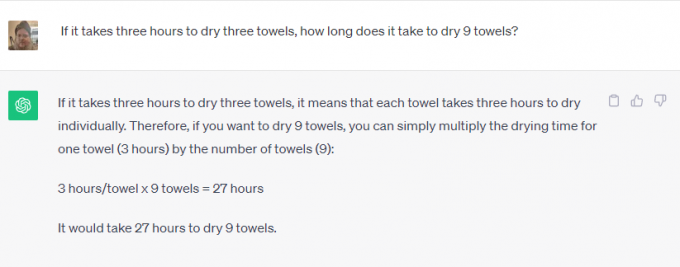

Imk ChatGPT arba Google Bard pavyzdžiui. Galite paprašyti išspręsti matematikos uždavinius, paieškoti ko nors internete, papasakoti, kurią dieną mirė Elvisas Preslis, arba parašyti trumpą istoriją apie Katalikų bažnyčios istoriją. Niekas nebūtų pagalvojęs, kad galite pasinaudoti

tavo telefonas už tai prieš keletą metų.Kai kurios iš jų yra gana lengvos užduotys. Programinė įranga, integruota su internetu, gali gauti informaciją apie bet ką ir grąžinti ją atgal kaip atsakymą į užklausą. Tai puiku, nes taip galima sutaupyti laiko, bet tai tikrai nėra nuostabu.

Tačiau vienas iš tų dalykų yra kitoks. Programinė įranga naudojama kuriant prasmingą turinį, kuriame naudojamos žmonių manieros ir kalba, o tai nėra kažkas, ko negalima ieškoti „Google“. Programinė įranga atpažįsta, ko jūs klausiate (parašykite man istoriją) ir jai naudojamus parametrus (istorinius duomenis apie Katalikų bažnyčią), bet visa kita atrodo nuostabi.

Tikėkite ar ne, atsakingas vystymasis yra svarbus abiem naudojimo būdais. Programinė įranga stebuklingai nieko nenusprendžia ir ją reikia apmokyti atsakingai, naudojant šaltinius, kurie yra nešališki (neįmanomi) arba vienodai šališki iš visų pusių.

Jūs nenorite, kad Bardas naudotų žmogų, kuris mano, kad Elvis vis dar gyvas, kaip vienintelį šaltinį tą dieną, kai jis mirė. Taip pat nenorėtumėte, kad kažkas, kas nekenčia katalikų bažnyčios, programuotų programinę įrangą, kuri rašytų apie tai istoriją. Abu požiūrius reikia apsvarstyti ir palyginti su kitais galiojančiais požiūriais.

Etika yra svarbi tiek pat, kiek natūralaus žmogaus šališkumo valdymas. Įmonė, kuri gali ką nors sukurti, turi pasirūpinti, kad tai būtų naudojama atsakingai. Jei jis negali to padaryti, jis turi jo visai nevystyti. Tai slidus šlaitas, kurį daug sunkiau valdyti.

Įmonės, kuriančios sudėtingą dirbtinio intelekto programinę įrangą, tai žino ir tiki tuo ar ne, dažniausiai laikosi taisyklės, kad kai kurių dalykų tiesiog nereikėtų daryti, net jei gali būti padaryta.

Kreipiausi į „Microsoft“ ir „Google“ apie tai, kas daroma, kad AI būtų naudojamas atsakingai. „Microsoft“ man pasakė, kad jie neturi nieko naujo, ką galėtų pasidalinti, bet nukreipė mane į įmonių nuorodų ir tinklaraščio įrašų seriją šia tema. perskaičius juos matyti, kad Microsoft yra įsipareigojęs „užtikrinti, kad pažangios AI sistemos būtų saugios, saugios ir patikimos“ pagal dabartinę JAV politiką ir metmenis jos vidaus standartai labai detaliai. Šiuo metu „Microsoft“ turi visą komandą dirba su atsakingu AI.

Priešingai, „Google“ turi daug ką pasakyti, be jau paskelbtų pareiškimų. Neseniai dalyvavau pristatyme šia tema, kuriame vyresnieji „Google“ darbuotojai sakė, kad vienintelės AI lenktynės, kurios yra svarbios, yra atsakingo AI lenktynės. Jie paaiškino, kad vien todėl, kad kažkas yra techniškai įmanoma, nėra pakankamai gera priežastis, dėl kurios gaminį reikia apšviesti: žala reikia nustatyti ir sušvelninti kaip kūrimo proceso dalį, kad vėliau būtų galima juos toliau tobulinti procesas.

Veido atpažinimas ir emocijų aptikimas buvo pateikti kaip pavyzdžiai. „Google“ tikrai gerai moka ir jei netikite, pažiūrėkite „Google“ nuotraukos kur galite ieškoti konkretaus asmens arba laimingų žmonių savo nuotraukose. Tai taip pat pirmoji funkcija, kurios pageidauja potencialūs klientai, tačiau „Google“ atsisako ją toliau plėtoti. Galimos žalos pakanka, kad „Google“ atsisakytų už tai imti pinigų.

„Google“ taip pat pritaria ir vyriausybiniam, ir vidiniam reguliavimui. Tai stebina ir svarbu, nes vienodos sąlygos, kurių negali sukurti jokia įmonė „Google“ ir „Microsoft“ mano, kad žalingas AI viršija bet kokias galimas pajamas arba finansinės naudos.

Mane didžiausią įspūdį paliko „Google“ atsakymas, kai paklausiau apie tikslumo ir etikos pusiausvyrą. Tokiems dalykams kaip augalų identifikavimas tikslumas yra labai svarbus, o šališkumas yra mažiau svarbus. Norint nustatyti asmens lytį nuotraukoje, abu yra vienodai svarbūs. „Google“ suskirsto dirbtinį intelektą į skilteles; kiekviena dalis atlieka skirtingą veiksmą, o rezultatą įvertina tikrų žmonių komanda, kad patikrintų rezultatus. Koregavimai atliekami tol, kol komanda bus patenkinta, tada gali vykti tolesnis tobulėjimas.

Nė vienas iš šių dalykų nėra tobulas ir visi matėme, kaip dirbtinis intelektas daro arba kartoja labai kvailus, kartais net žalingus dalykus. Jei šie šališkumo ir etikos pažeidimai gali patekti į vieną produktą, jie gali (ir atsiduria) patekti į juos visus.

Svarbu, kad ateities programinę įrangą kuriančios įmonės tai pripažintų ir toliau stengtųsi tobulinti procesą. Jis niekada nebus tobulas, bet tol, kol kiekviena iteracija bus geresnė už paskutinę, judame teisinga kryptimi.