Probabilmente hai sentito o letto persone parlare di IA etica. Mentre i computer in realtà non possono pensare e quindi non hanno reali pregiudizi o senso di responsabilità, le persone che sviluppano il software che alimenta tutto lo fanno certamente e questo è ciò che lo rende importante.

Non è una cosa facile da descrivere o da notare. Ciò non toglie nulla a quanto sia vitale che le grandi aziende tecnologiche che sviluppano prodotti rivolti al consumatore basati sull’intelligenza artificiale lo facciano bene. Diamo un'occhiata a cos'è e cosa viene fatto per garantire che l'intelligenza artificiale renda le nostre vite migliori invece che peggiori.

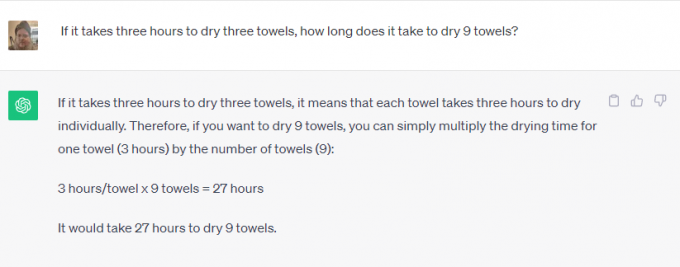

L’intelligenza artificiale non è altro che un pezzo di software che assorbe qualcosa, lo elabora e sputa fuori qualcos’altro. In realtà, questo è ciò che fanno tutti i software. Ciò che rende l’intelligenza artificiale diversa è che l’output può essere molto diverso dall’input.

Android e relax

Una delle rubriche tecnologiche più longeve del web,

Android e relax è la tua discussione del sabato su Android, Google e tutto ciò che riguarda la tecnologia.Prendere ChatGPT O Google Bardo ad esempio. Puoi chiedere di risolvere problemi di matematica, cercare qualcosa sul web, dirti in che giorno è morto Elvis Presley o scriverti un breve racconto sulla storia della chiesa cattolica. Nessuno avrebbe pensato che avresti potuto usarla il tuo telefono per questo qualche anno fa.

Alcuni di questi sono compiti piuttosto facili. Il software integrato con Internet può recuperare informazioni su qualsiasi cosa e rigurgitarle come risposta a una query. È fantastico perché può far risparmiare tempo, ma non è davvero sorprendente.

Una di queste cose è diversa, però. Il software viene utilizzato per creare contenuti significativi che utilizzano i manierismi e il linguaggio umano, che non è qualcosa che può essere cercato su Google. Il software riconosce ciò che chiedi (scrivimi una storia) e i parametri da utilizzare (dati storici sulla chiesa cattolica) ma il resto sembra sorprendente.

Che tu ci creda o no, lo sviluppo responsabile è importante in entrambi i tipi di utilizzo. Il software non decide magicamente nulla e deve essere addestrato in modo responsabile, utilizzando fonti che sono imparziali (impossibili) o ugualmente parziali da tutti i lati.

Non vuoi che Bard utilizzi qualcuno che pensa che Elvis sia ancora vivo come unica fonte per il giorno della sua morte. Inoltre, non vorrai che qualcuno che odia la Chiesa cattolica programmi un software utilizzato per scrivere una storia al riguardo. Entrambi i punti di vista devono essere considerati e confrontati con altri punti di vista validi.

L’etica conta tanto quanto tenere sotto controllo i naturali pregiudizi umani. Un’azienda che può sviluppare qualcosa deve assicurarsi che venga utilizzata in modo responsabile. Se non può farlo, non deve svilupparlo affatto. Si tratta di un terreno scivoloso, molto più difficile da gestire.

Le aziende che sviluppano complessi software di intelligenza artificiale ne sono consapevoli e, che ci crediate o no, per lo più seguono la regola secondo cui alcune cose non dovrebbero essere fatte anche se Potere essere fatto.

Ho contattato sia Microsoft che Google per sapere cosa si sta facendo per garantire che l'intelligenza artificiale venga utilizzata in modo responsabile. Microsoft mi ha detto che non avevano nulla di nuovo da condividere ma mi ha indirizzato a una serie di collegamenti aziendali e post di blog sull'argomento. leggerli mostra che Microsoft si impegna a "garantire che i sistemi avanzati di intelligenza artificiale siano sicuri, protetti e affidabili" in conformità con l'attuale politica e le linee guida degli Stati Uniti i suoi standard interni in grande dettaglio. Microsoft attualmente ha un intero team lavorare su un’intelligenza artificiale responsabile.

Al contrario, Google ha molto da dire oltre alle dichiarazioni già pubblicate. Recentemente ho partecipato a una presentazione sull’argomento in cui i dipendenti senior di Google hanno affermato che l’unica corsa all’intelligenza artificiale che conta è la corsa all’intelligenza artificiale responsabile. Hanno spiegato che solo perché qualcosa è tecnicamente possibile non è una ragione sufficiente per dare il via libera a un prodotto: danneggia devono essere identificati e mitigati come parte del processo di sviluppo in modo da poter poi essere utilizzati per perfezionarlo ulteriormente processi.

Come esempi sono stati forniti il riconoscimento facciale e il rilevamento emotivo. Google è davvero bravo in entrambi e se non ci credi, dai un'occhiata Google Foto dove puoi cercare una persona specifica o persone felici nelle tue foto. È anche la funzionalità numero uno richiesta dai potenziali clienti, ma Google si rifiuta di svilupparla ulteriormente. Il danno potenziale è sufficiente perché Google si rifiuti di accettare soldi per questo.

Anche Google è a favore sia della regolamentazione governativa che della regolamentazione interna. Ciò è allo stesso tempo sorprendente e importante perché crea condizioni di parità che nessuna azienda può creare L'intelligenza artificiale dannosa è qualcosa che sia Google che Microsoft ritengono superi qualsiasi potenziale reddito o guadagno finanziario.

Ciò che mi ha colpito di più è stata la risposta di Google quando ho chiesto come bilanciare accuratezza ed etica. Per qualcosa come l'identificazione delle piante, la precisione è molto importante mentre il bias è meno importante. Per qualcosa come identificare il sesso di qualcuno in una foto, entrambi sono ugualmente importanti. Google suddivide l'intelligenza artificiale in quelle che chiama sezioni; ogni fetta fa una cosa diversa e il risultato viene valutato da un team di persone reali per verificare i risultati. Gli aggiustamenti vengono apportati fino a quando il team non è soddisfatto, quindi può avvenire un ulteriore sviluppo.

Niente di tutto questo è perfetto e tutti abbiamo visto le IA fare o ripetere cose molto stupide, a volte anche dolorose. Se questi pregiudizi e violazioni etiche riescono a trovare la loro strada in un prodotto, possono trovarsi (e lo fanno) in tutti loro.

L'importante è che le aziende che sviluppano il software del futuro lo riconoscano e continuino a cercare di migliorare il processo. Non sarà mai perfetto, ma finché ogni iterazione sarà migliore della precedente ci stiamo muovendo nella giusta direzione.