Probablemente hayas oído o leído a personas hablar sobre la IA ética. Si bien las computadoras en realidad no pueden pensar y, por lo tanto, no tienen prejuicios ni sentido de responsabilidad, las personas que desarrollan el software que lo impulsa todo ciertamente lo hacen y eso es lo que lo hace importante.

No es algo fácil de describir o notar. Eso no quita nada a lo vital que es que las grandes empresas tecnológicas que desarrollan productos orientados al consumidor impulsados por IA lo hagan bien. Echemos un vistazo a qué es y qué se está haciendo para garantizar que la IA mejore nuestras vidas en lugar de empeorarlas.

La IA no es más que un trozo de software que toma algo, lo procesa y escupe algo más. Realmente, eso es lo que hace todo el software. Lo que hace que la IA sea diferente es que la salida puede ser muy diferente de la entrada.

Android y relajarse

Una de las columnas de tecnología más antiguas de la web, Android y relajarse es su discusión del sábado sobre Android, Google y todo lo relacionado con la tecnología.

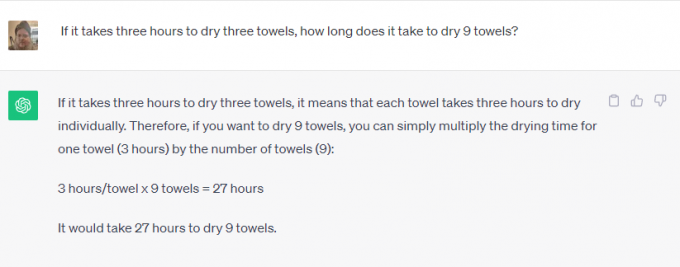

Llevar ChatGPT o bardo de google por ejemplo. Puedes pedirle que resuelva problemas de matemáticas, buscar algo en la web, que te diga qué día murió Elvis Presley o que te escriba un cuento breve sobre la historia de la iglesia católica. Nadie hubiera pensado que podrías usar su teléfono por esto hace unos años.

Algunas de ellas son tareas bastante fáciles. El software integrado con Internet puede obtener información sobre cualquier cosa y regurgitarla como respuesta a una consulta. Es genial porque puede ahorrar tiempo, pero en realidad no es sorprendente.

Sin embargo, una de esas cosas es diferente. El software se utiliza para crear contenido significativo que utiliza gestos y habla humanos, algo que no se puede buscar en Google. El software reconoce lo que estás preguntando (escríbeme una historia) y los parámetros que se utilizarán para ello (datos históricos sobre la iglesia católica) pero el resto parece sorprendente.

Lo creas o no, el desarrollo responsable es importante en ambos tipos de uso. El software no decide nada mágicamente y debe entrenarse de manera responsable, utilizando fuentes que sean imparciales (imposible) o igualmente sesgadas desde todos los lados.

No querrás que Bard utilice a alguien que cree que Elvis todavía está vivo como única fuente para el día de su muerte. Tampoco querrías que alguien que odia a la Iglesia católica programara el software utilizado para escribir una historia sobre ella. Ambos puntos de vista deben considerarse y sopesarse con otros puntos de vista válidos.

La ética importa tanto como mantener bajo control los prejuicios humanos naturales. Una empresa que puede desarrollar algo debe asegurarse de que se utilice de forma responsable. Si no puede hacer eso, no necesita desarrollarlo en absoluto. Se trata de una pendiente resbaladiza, mucho más difícil de gestionar.

Las empresas que desarrollan software de inteligencia artificial complejo son conscientes de esto y, lo crean o no, en su mayoría siguen la regla que dice que algunas cosas simplemente no deberían fabricarse incluso si poder hacerse.

Me comuniqué con Microsoft y Google sobre lo que se está haciendo para garantizar que la IA se utilice de manera responsable. Microsoft me dijo que no tenían nada nuevo que compartir, pero me dirigió a una serie de enlaces corporativos y publicaciones de blogs sobre el tema. leerlos muestra que Microsoft está comprometido a "garantizar que los sistemas avanzados de IA sean seguros y confiables" de acuerdo con la política y los esquemas actuales de EE. UU. sus normas internas en gran detalle. Microsoft actualmente tiene un equipo completo trabajando en una IA responsable.

Por el contrario, Google tiene mucho que decir además de sus declaraciones ya publicadas. Hace poco asistí a una presentación sobre el tema en la que empleados de alto nivel de Google dijeron que la única carrera de IA que importa es la carrera por una IA responsable. Explicaron que sólo porque algo sea técnicamente posible no es razón suficiente para dar luz verde a un producto: daña deben identificarse y mitigarse como parte del proceso de desarrollo para que luego puedan usarse para refinar aún más ese proceso.

Se dieron como ejemplos el reconocimiento facial y la detección emocional. Google es muy bueno en ambas cosas y si no lo crees, echa un vistazo a Fotos de Google donde puedes buscar una persona específica o personas felices en tus propias imágenes. También es la característica número uno solicitada por los clientes potenciales, pero Google se niega a desarrollarla más. El daño potencial es suficiente para que Google se niegue a aceptar dinero por ello.

Google también está a favor tanto de la regulación gubernamental como de la regulación interna. Esto es a la vez sorprendente e importante porque un campo de juego nivelado donde ninguna empresa puede crear La IA dañina es algo que tanto Google como Microsoft creen que supera cualquier ingreso potencial o ganancia financiera.

Lo que más me impresionó fue la respuesta de Google cuando le pregunté sobre el equilibrio entre precisión y ética. Para algo como la identificación de plantas, la precisión es muy importante, mientras que el sesgo es menos importante. Para algo como identificar el género de alguien en una foto, ambos son igualmente importantes. Google divide la IA en lo que llama porciones; cada porción hace una cosa diferente y el resultado es evaluado por un equipo de personas reales para verificar los resultados. Se realizan ajustes hasta que el equipo está satisfecho y luego puede ocurrir un mayor desarrollo.

Nada de esto es perfecto y todos hemos visto a la IA hacer o repetir cosas muy estúpidas, a veces incluso hirientes. Si estos sesgos y violaciones éticas pueden llegar a un producto, pueden (y de hecho lo hacen) llegar a todos ellos.

Lo importante es que las empresas que desarrollan el software del futuro lo reconozcan y sigan intentando mejorar el proceso. Nunca será perfecto, pero mientras cada iteración sea mejor que la anterior, avanzaremos en la dirección correcta.