Más de 350 expertos en tecnología, investigadores de IA y líderes de la industria firmaron el Declaración sobre el riesgo de IA publicado por el Centro para la seguridad de la IA esta semana pasada. Es una advertencia de una sola oración muy breve y concisa para todos nosotros:

Mitigar el riesgo de extinción de la IA debería ser una prioridad mundial junto con otros riesgos a escala social, como las pandemias y la guerra nuclear.

Entonces, los expertos en IA, incluidos los ingenieros prácticos de Google y Microsoft que están liberando activamente la IA sobre el mundo, piensa que la IA tiene el potencial de ser un evento de extinción global en la misma línea que la nuclear guerra. ¡Ay!

Admito que pensé lo mismo que mucha gente cuando leyó esta declaración por primera vez: eso es un montón de tonterías. Sí, la IA tiene muchos problemas y creo que es un poco pronto para apoyarse tanto como lo están haciendo algunas empresas de tecnología y noticias, pero ese tipo de hipérbole es simplemente una tontería.

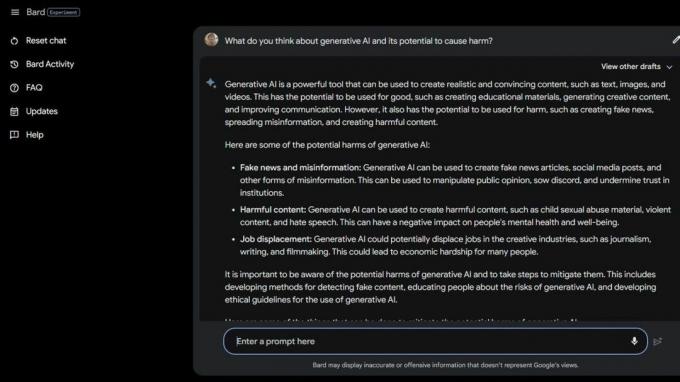

Luego hice algunos Google de Bard Beta Lab AI y encontró varias formas en que la IA ya es dañina. Algunas de las personas más vulnerables de la sociedad corren un riesgo aún mayor debido a la IA generativa y lo estúpidas que son en realidad estas computadoras inteligentes.

La Asociación Nacional de Trastornos de la Alimentación despidió a sus operadores de la línea de ayuda el 25 de mayo de 2023 y los reemplazó con Tessa the ChatBot. Los trabajadores estaban en medio de la sindicalización, pero NEDA afirma que "este fue un cambio largamente esperado y que AI puede mejorar servir a las personas con trastornos alimentarios" y no tenía nada que ver con seis empleados pagados y una variedad de voluntarios que intentaban sindicar.

El 30 de mayo de 2023, NEDA deshabilitado Tessa el ChatBot porque estaba ofreciendo consejos dañinos a personas con trastornos alimentarios graves. Oficialmente, NEDA está "preocupada y está trabajando con el equipo de tecnología y el equipo de investigación para investigar esto más a fondo; ese lenguaje va en contra de nuestras políticas y creencias fundamentales como organización de trastornos alimentarios".

En los EE. UU. hay 30 millones de personas con trastornos alimentarios graves y 10.200 morirán cada año como resultado directo de ellos. Uno cada hora.

Luego tenemos a Koko, una organización sin fines de lucro dedicada a la salud mental que usó la IA como un experimento en adolescentes suicidas. Sí, lo leiste bien.

Los usuarios en riesgo fueron canalizados al sitio web de Koko desde las redes sociales, donde cada uno fue colocado en uno de dos grupos. A un grupo se le proporcionó un número de teléfono de una línea directa de crisis real donde, con suerte, podrían encontrar la ayuda y el apoyo que necesitaban.

El otro grupo obtuvo el experimento de Koko en el que tuvieron que hacer un cuestionario y se les pidió que identificaran las cosas que desencadenaron sus pensamientos y lo que estaban haciendo para lidiar con ellos.

Una vez que terminaron, la IA les preguntó si revisarían las notificaciones de sus teléfonos al día siguiente. Si la respuesta era sí, los empujaban a una pantalla que decía "¡Gracias por eso! ¡Aquí hay un gato!" Por supuesto, había una imagen de un gato, y aparentemente, Koko y el investigador de IA que ayudaron a crear esto piensan que mejorará las cosas de alguna manera.

No estoy calificado para hablar sobre la ética de situaciones como esta en las que la IA se usa para proporcionar diagnósticos o ayudar a las personas que luchan contra la salud mental. Soy un experto en tecnología que se enfoca principalmente en teléfonos inteligentes. Sin embargo, la mayoría de los expertos humanos están de acuerdo en que la práctica está plagada de problemas. Sé que el tipo equivocado de "ayuda" puede y hará que una mala situación sea mucho peor.

Si tiene problemas con su salud mental o siente que necesita ayuda, llame o envíe un mensaje de texto al 988 para hablar con un ser humano que pueda ayudarlo.

Este tipo de historias cuentan dos cosas: la IA es muy problemática cuando se usa en lugar de personas calificadas en el caso de una crisis, y las personas reales que se supone que saben mejor también pueden ser tontas.

La IA en su estado actual no está lista para usarse de esta manera. Ni siquiera cerca. La profesora de la Universidad de Washington Emily M. Bender hace un gran punto en una declaración a vice:

"Los modelos de lenguaje grande son programas para generar texto que suene plausible dados sus datos de entrenamiento y un indicador de entrada. No tienen empatía, ni comprensión del lenguaje que producen, ni comprensión de la situación en la que se encuentran. Pero el texto que producen suena plausible y, por lo tanto, es probable que las personas le asignen un significado. Lanzar algo así en situaciones delicadas es correr riesgos desconocidos".

Quiero negar lo que estoy viendo y leyendo para poder pretender que las personas no están tomando atajos o tratando de ahorrar dinero usando IA de formas tan dañinas. La sola idea me repugna. Pero no puedo porque la IA todavía es tonta y aparentemente también lo son muchas personas que quieren usarla.

Tal vez la idea de un evento de extinción masiva debido a la IA no sea una idea tan descabellada después de todo.