Du har sikkert hørt eller læst folk, der taler om etisk kunstig intelligens. Selvom computere faktisk ikke kan tænke og derfor ikke har nogen egentlig bias eller ansvarsfølelse, gør de mennesker, der udvikler softwaren, der driver det hele, bestemt, og det er det, der gør det vigtigt.

Det er ikke let at beskrive eller lægge mærke til. Det tager ikke noget fra, hvor vigtigt det er, at store teknologivirksomheder, der udvikler forbrugerorienterede produkter drevet af AI, gør det rigtigt. Lad os tage et kig på, hvad det er, og hvad der bliver gjort for at sikre, at AI gør vores liv bedre i stedet for værre.

AI er intet mere end en del af software, der tager noget ind, behandler det og spytter noget andet ud. Det er virkelig, hvad al software gør. Det, der gør AI anderledes, er, at outputtet kan være meget anderledes end inputtet.

Android & Chill

En af nettets længstvarende teknologikolonner, Android & Chill er din lørdagsdiskussion om Android, Google og alt det tekniske.

Tage

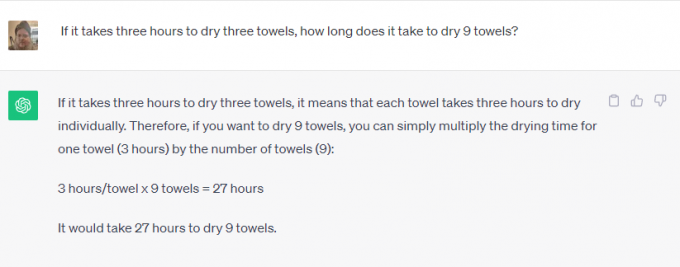

ChatGPT eller Google Bard for eksempel. Du kan enten bede om at løse matematiske problemer, slå noget op på nettet, fortælle dig, hvilken dag Elvis Presley døde, eller skrive dig en novelle om den katolske kirkes historie. Ingen ville have troet, du kunne bruge din telefon for dette for nogle år siden.Nogle af dem er ret nemme opgaver. Software, der er integreret med internettet, kan hente information om hvad som helst og sende det tilbage som et svar på en forespørgsel. Det er fantastisk, fordi det kan spare tid, men det er egentlig ikke fantastisk.

En af de ting er dog anderledes. Software bruges til at skabe meningsfuldt indhold, der bruger menneskelige manerer og tale, hvilket ikke er noget, der kan slås op på Google. Softwaren genkender, hvad du spørger om (skriv mig en historie) og de parametre, der skal bruges til det (historiske data om den katolske kirke), men resten virker fantastisk.

Tro det eller ej, ansvarlig udvikling betyder noget for begge typer brug. Software bestemmer ikke noget på magisk vis, og det skal trænes ansvarligt ved at bruge kilder, der enten er upartiske (umulige) eller lige partiske fra alle sider.

Du vil ikke have, at Bard bruger en, der tror, at Elvis stadig er i live, som den eneste kilde til den dag, han døde. Du vil heller ikke have, at nogen, der hader den katolske kirke, skal programmere software, der bruges til at skrive en historie om den. Begge synspunkter skal overvejes og vejes mod andre gyldige synspunkter.

Etik betyder lige så meget som at holde den naturlige menneskelige skævhed i skak. En virksomhed, der kan udvikle noget, skal sørge for, at det bliver brugt ansvarligt. Hvis den ikke kan gøre det, skal den slet ikke udvikle den. Det er en glidebane - en der er meget sværere at håndtere.

De virksomheder, der udvikler indviklet AI-software, er klar over dette og tro det eller ej, følger for det meste reglen om, at nogle ting bare ikke bør laves, selvom de kan blive lavet.

Jeg kontaktede både Microsoft og Google om, hvad der bliver gjort for at sikre, at AI bliver brugt ansvarligt. Microsoft fortalte mig, at de ikke havde noget nyt at dele, men henviste mig til en række firmalinks og blogindlæg om emnet. gennemlæsning af dem viser, at Microsoft er forpligtet til "sikre, at avancerede AI-systemer er sikre, sikre og troværdige" i overensstemmelse med den nuværende amerikanske politik og skitser sine interne standarder meget detaljeret. Microsoft har i øjeblikket et helt team arbejder med ansvarlig AI.

I modsætning hertil har Google meget at sige ud over sine allerede offentliggjorte udtalelser. Jeg deltog for nylig i en præsentation om emnet, hvor senior Google-medarbejdere sagde, at det eneste AI-race, der betyder noget, er kapløbet om ansvarlig AI. De forklarede, at bare fordi noget er teknisk muligt, er det ikke en god nok grund til at give grønt lys for et produkt: skader skal identificeres og afbødes som en del af udviklingsprocessen, så de derefter kan bruges til at forfine det yderligere behandle.

Ansigtsgenkendelse og følelsesmæssig detektion blev givet som eksempler. Google er rigtig god til begge dele, og hvis du ikke tror på det, så tag et kig på Google Fotos hvor du kan søge efter en bestemt person eller efter glade mennesker i dine egne billeder. Det er også den første funktion, som potentielle kunder efterspørger, men Google nægter at udvikle den yderligere. Den potentielle skade er nok til, at Google nægter at tage penge for det.

Google går også ind for både statslig regulering og intern regulering. Det er både overraskende og vigtigt, fordi et lige vilkår, hvor ingen virksomhed kan skabe skadelig AI er noget, som både Google og Microsoft mener opvejer enhver potentiel indkomst eller økonomisk gevinst.

Det, der imponerede mig mest, var Googles svar, da jeg spurgte om afvejning af nøjagtighed og etik. For noget som planteidentifikation er nøjagtighed meget vigtig, mens bias er mindre vigtig. For noget som at identificere en persons køn på et billede, er begge dele lige vigtige. Google bryder AI i, hvad det kalder skiver; hver skive gør en anden ting, og resultatet evalueres af et team af rigtige mennesker for at tjekke resultaterne. Der justeres indtil teamet er tilfreds, så kan der ske yderligere udvikling.

Intet af dette er perfekt, og vi har alle set AI gøre eller gentage meget dumme ting, nogle gange endda sårende ting. Hvis disse skævheder og etiske brud kan finde vej til ét produkt, kan (og gør) de finde vej ind i dem alle.

Det vigtige er, at de virksomheder, der udvikler fremtidens software, erkender dette og bliver ved med at forsøge at forbedre processen. Det bliver aldrig perfekt, men så længe hver iteration er bedre end den sidste, bevæger vi os i den rigtige retning.