Podpis podepsalo více než 350 technologických expertů, výzkumníků AI a lídrů v oboru Prohlášení o riziku umělé inteligence publikoval Centrum pro bezpečnost AI tento minulý týden. Je to velmi krátké a výstižné varování jednou větou pro nás všechny:

Zmírnění rizika vyhynutí v důsledku umělé inteligence by mělo být globální prioritou spolu s dalšími riziky společenského rozsahu, jako jsou pandemie a jaderná válka.

Tedy odborníci na AI, včetně praktických inženýrů z Googlu a Microsoftu, kteří aktivně AI rozpoutávají na světě, myslet si, že umělá inteligence má potenciál stát se globálním zánikem ve stejném duchu jako jaderná válka. Fuj.

Přiznám se, že jsem si myslel to samé, co si mnozí lidé mysleli, když poprvé četli toto prohlášení – to je hromada sraček. Ano AI má spoustu problémů a myslím, že je trochu brzy se o to opřít stejně jako některé technologické a zpravodajské společnosti, ale taková nadsázka je prostě hloupá.

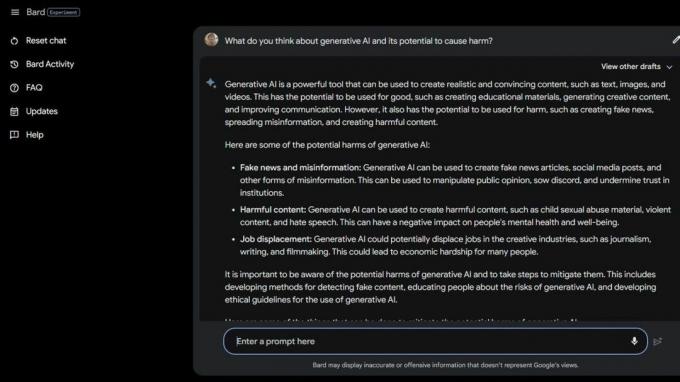

Pak jsem něco udělal Bard Beta Lab AI Google

a zjistili několik způsobů, jak je AI již škodlivá. Někteří z nejzranitelnějších společností jsou ještě více ohroženi kvůli generativní umělé inteligenci a kvůli tomu, jak hloupé tyto chytré počítače ve skutečnosti jsou.Národní asociace pro poruchy příjmu potravy propustil operátory své linky důvěry 25. května 2023 a nahradil je Tessou the ChatBot. Dělníci byli uprostřed odborů, ale NEDA tvrdí, že „to byla dlouho očekávaná změna a že umělá inteligence může sloužit lidem s poruchami příjmu potravy“ a neměl nic společného se šesti placenými zaměstnanci a různými dobrovolníky, kteří se o to pokoušeli syndikalizovat.

30. května 2023 NEDA deaktivoval Tessa the ChatBot protože nabízel škodlivé rady lidem s vážnými poruchami příjmu potravy. Oficiálně se NEDA „znepokojuje a spolupracuje s technologickým týmem a výzkumným týmem na dalším prozkoumání; tento jazyk je v rozporu s našimi zásadami a základním přesvědčením organizace zabývající se poruchami příjmu potravy."

V USA je 30 milionů lidí s vážnými poruchami příjmu potravy a 10 200 na ně každý rok zemře. Jedna každou hodinu.

Pak tu máme Koko, neziskovou organizaci zabývající se duševním zdravím použil AI jako experiment na sebevražedných teenagerech. Ano, čtete správně.

Rizikoví uživatelé byli přesměrováni na web Koko ze sociálních médií, kde byl každý zařazen do jedné ze dvou skupin. Jedné skupině bylo poskytnuto telefonní číslo na skutečnou krizovou horkou linku, kde by snad mohla najít potřebnou pomoc a podporu.

Druhá skupina dostala Kokoův experiment, kde si museli udělat kvíz a byli požádáni, aby identifikovali věci, které spouštěly jejich myšlenky, a co dělali, aby se s nimi vyrovnali.

Po dokončení se jich AI zeptala, zda by si příští den zkontrolovali oznámení z telefonu. Pokud byla odpověď ano, dostali se na obrazovku s nápisem „Díky za to! Tady je kočka!" Samozřejmě tam byl obrázek kočky a Koko a výzkumník umělé inteligence, který pomáhal vytvořit tohle, si myslí, že to nějak zlepší.

Nejsem kvalifikovaný mluvit o etice situací, jako je tato, kdy se AI používá k diagnostice nebo pomoci lidem, kteří bojují s duševním zdravím. Jsem technologický expert, který se většinou zaměřuje na chytré telefony. Většina lidských expertů se však shoduje, že tato praxe je plná problémů. Vím, že nesprávný druh „pomoci“ může a také zhorší špatnou situaci.

Pokud se potýkáte se svým duševním zdravím nebo máte pocit, že potřebujete pomoc, zavolejte nebo napište SMS na číslo 988 a promluvte si s člověkem, který vám může pomoci.

Tyto druhy příběhů vypovídají o dvou věcech – umělá inteligence je velmi problematická, když se v případě krize používá místo kvalifikovaných lidí, a skuteční lidé, kteří by to měli vědět lépe, mohou být také hloupí.

AI ve svém současném stavu není připravena k použití tímto způsobem. Ani zdaleka. Profesorka University of Washington Emily M. Bender v tom má skvělou pointu prohlášení pro Vice:

„Velké jazykové modely jsou programy pro generování věrohodně znějícího textu na základě jejich trénovacích dat a vstupní výzvy. Nemají empatii ani žádné porozumění jazyku, který produkují, ani žádné porozumění situaci, ve které se nacházejí. Ale text, který vytvářejí, zní věrohodně, a tak mu lidé pravděpodobně přiřadí význam. Vhazovat něco takového do citlivých situací znamená podstupovat neznámá rizika.“

Chci popřít to, co vidím a čtu, abych mohl předstírat, že lidé nepoužívají zkratky nebo se nesnaží ušetřit peníze používáním AI tak škodlivými způsoby. Už jen ta představa je mi protivná. Ale nemohu, protože umělá inteligence je stále hloupá a zjevně také mnoho lidí, kteří ji chtějí používat.

Možná, že myšlenka hromadného vymírání kvůli umělé inteligenci není nakonec tak vzdálená.