من المحتمل أنك سمعت أو قرأت أشخاصًا يتحدثون عن الذكاء الاصطناعي الأخلاقي. في حين أن أجهزة الكمبيوتر لا يمكنها التفكير فعليًا، وبالتالي ليس لديها أي تحيز فعلي أو إحساس بالمسؤولية، فإن الأشخاص الذين يطورون البرامج التي تشغلها جميعًا يفعلون ذلك بالتأكيد، وهذا ما يجعلها مهمة.

ليس من السهل وصفه أو ملاحظته. وهذا لا ينتقص من مدى أهمية قيام شركات التكنولوجيا الكبرى التي تطور منتجات موجهة للمستهلك مدعومة بالذكاء الاصطناعي بالقيام بذلك بشكل صحيح. دعونا نلقي نظرة على ماهيته وما يتم فعله للتأكد من أن الذكاء الاصطناعي يجعل حياتنا أفضل بدلاً من أن تكون أسوأ.

الذكاء الاصطناعي ليس أكثر من مجرد جزء من البرامج التي تستقبل شيئًا ما، وتعالجه، وتنتج شيئًا آخر. حقا، هذا ما تفعله كل البرامج. ما يجعل الذكاء الاصطناعي مختلفًا هو أن المخرجات يمكن أن تكون مختلفة تمامًا عن المدخلات.

الروبوت والبرد

أحد أطول الأعمدة التقنية على الويب، الروبوت والبرد هي مناقشتك يوم السبت حول Android وGoogle وكل ما يتعلق بالتكنولوجيا.

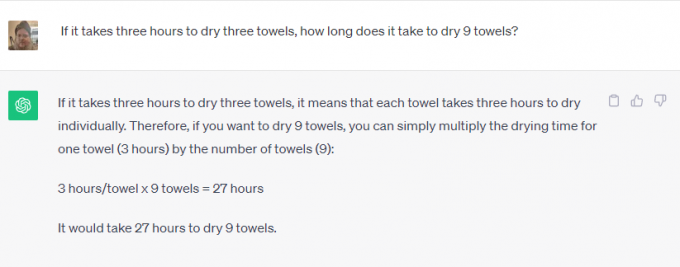

يأخذ ChatGPT أو جوجل بارد على سبيل المثال. يمكنك أن تطلب إما حل مسائل رياضية، أو البحث عن شيء ما على الويب، أو إخبارك باليوم الذي توفي فيه إلفيس بريسلي، أو كتابة قصة قصيرة عن تاريخ الكنيسة الكاثوليكية. لم يكن أحد يعتقد أنه يمكنك استخدامها

هاتفك لهذا قبل بضع سنوات.بعض هذه المهام سهلة جدًا. يمكن للبرامج المدمجة مع الإنترنت جلب معلومات حول أي شيء ثم استرجاعها مرة أخرى كرد على استفسار. إنه أمر رائع لأنه يمكن أن يوفر الوقت، لكنه ليس رائعًا حقًا.

لكن أحد هذه الأشياء مختلف. تُستخدم البرامج لإنشاء محتوى ذي معنى يستخدم السلوكيات والكلام البشري، وهو أمر لا يمكن البحث عنه على Google. يتعرف البرنامج على ما تطلبه (اكتب لي قصة) والمعلمات التي سيتم استخدامها لها (بيانات تاريخية عن الكنيسة الكاثوليكية)، لكن الباقي يبدو مذهلاً.

صدق أو لا تصدق، التطوير المسؤول مهم في كلا النوعين من الاستخدام. البرمجيات لا تقرر أي شيء بطريقة سحرية ويجب تدريبها بشكل مسؤول، باستخدام مصادر إما غير متحيزة (مستحيلة) أو متحيزة بشكل متساوٍ من جميع الجوانب.

لا تريد أن يستخدم بارد شخصًا يعتقد أن إلفيس لا يزال على قيد الحياة كمصدر وحيد ليوم وفاته. أنت أيضًا لا تريد أن يقوم شخص يكره الكنيسة الكاثوليكية ببرمجة برنامج يستخدم لكتابة قصة عنها. ويجب أخذ وجهتي النظر في الاعتبار ومقارنتهما بوجهات النظر الصحيحة الأخرى.

إن الأخلاقيات مهمة بقدر أهمية إبقاء التحيز البشري الطبيعي تحت السيطرة. تحتاج الشركة التي يمكنها تطوير شيء ما إلى التأكد من استخدامه بشكل مسؤول. إذا لم تتمكن من القيام بذلك، فلا تحتاج إلى تطويره على الإطلاق. وهذا منحدر زلق، وهو منحدر يصعب إدارته كثيرًا.

تدرك الشركات التي تطور برامج الذكاء الاصطناعي المعقدة هذا الأمر وصدق أو لا تصدق، وتتبع في الغالب القاعدة التي تنص على أنه لا ينبغي صنع بعض الأشياء حتى لو تم تصنيعها. يستطيع مصنوع.

لقد تواصلت مع كل من Microsoft وGoogle بشأن ما يتم فعله للتأكد من استخدام الذكاء الاصطناعي بشكل مسؤول. أخبرتني شركة Microsoft بأنه ليس لديها أي شيء جديد لمشاركته، ولكنها وجهتني إلى سلسلة من روابط الشركات ومنشورات المدونات حول هذا الموضوع. القراءة من خلالها تبين أن Microsoft ملتزم ب "التأكد من أن أنظمة الذكاء الاصطناعي المتقدمة آمنة ومأمونة وجديرة بالثقة" وفقًا للسياسة والخطوط العريضة الحالية للولايات المتحدة معاييرها الداخلية في تفاصيل عظيمة. لدى Microsoft حاليًا فريق كامل العمل على الذكاء الاصطناعي المسؤول.

في المقابل، لدى جوجل الكثير لتقوله بالإضافة إلى تصريحاتها المنشورة بالفعل. لقد حضرت مؤخرًا عرضًا تقديميًا حول الموضوع حيث قال كبار موظفي Google إن سباق الذكاء الاصطناعي الوحيد الذي يهم هو السباق من أجل الذكاء الاصطناعي المسؤول. لقد أوضحوا أن مجرد كون شيء ما ممكنًا من الناحية الفنية ليس سببًا كافيًا لإعطاء الضوء الأخضر للمنتج: الأضرار يجب تحديدها وتخفيفها كجزء من عملية التطوير حتى يمكن استخدامها بعد ذلك لتحسين ذلك عملية.

تم تقديم التعرف على الوجه والكشف العاطفي كأمثلة. جوجل جيد حقًا في كليهما، وإذا كنت لا تصدق ذلك، قم بإلقاء نظرة عليه صور جوجل حيث يمكنك البحث عن شخص معين أو عن أشخاص سعداء في صورك الخاصة. إنها أيضًا الميزة الأولى التي يطلبها العملاء المحتملون ولكن Google ترفض تطويرها بشكل أكبر. الضرر المحتمل يكفي لرفض Google قبول الأموال مقابل ذلك.

تؤيد Google أيضًا التنظيم الحكومي وكذلك التنظيم الداخلي. وهذا أمر مثير للدهشة ومهم في نفس الوقت، نظرًا لوجود ساحة لعب متكافئة حيث لا يمكن لأي شركة أن تخلقها الذكاء الاصطناعي الضار هو شيء تعتقد كل من جوجل ومايكروسوفت أنه يفوق أي دخل أو دخل محتمل مكاسب مالية.

أكثر ما أثار إعجابي هو استجابة Google عندما سألتها عن الموازنة بين الدقة والأخلاق. بالنسبة لشيء مثل تحديد النبات، تعد الدقة مهمة جدًا بينما يكون التحيز أقل أهمية. بالنسبة لشيء مثل تحديد جنس شخص ما في الصورة، كلاهما لهما نفس القدر من الأهمية. تقوم جوجل بتقسيم الذكاء الاصطناعي إلى ما تسميه شرائح؛ تقوم كل شريحة بشيء مختلف ويتم تقييم النتيجة بواسطة فريق من الأشخاص الحقيقيين للتحقق من النتائج. يتم إجراء التعديلات حتى يصبح الفريق راضيًا، ومن ثم يمكن إجراء المزيد من التطوير.

لا شيء من هذا مثالي، وقد رأينا جميعًا أن الذكاء الاصطناعي يفعل أو يكرر أشياء غبية جدًا، وأحيانًا أشياء مؤذية. إذا تمكنت هذه التحيزات والانتهاكات الأخلاقية من إيجاد طريقها إلى منتج واحد، فيمكنها (وهذا ما يحدث بالفعل) أن تجد طريقها إلى جميع المنتجات.

المهم هو أن الشركات التي تقوم بتطوير برامج المستقبل تدرك ذلك وتستمر في محاولة تحسين العملية. لن يكون الأمر مثاليًا أبدًا، ولكن طالما أن كل تكرار أفضل من الأخير، فإننا نتحرك في الاتجاه الصحيح.